Pazarlama İpuçları, Gündem ve Daha Fazlası

AnalyticaHouse’un güçlü iş ortaklıklarından beslenen deneyimi ile güncel trendler, stratejik içgörüler ve sektörel derinlik içeren blog yazılarımızı keşfedin.

GA4'da En Sık Karşılaşılan 5 Raporlama Hatası

Ekim 2020’de beta olarak yayımlanan GA4, Temmuz 2023 itibarıyla tüm 360 dışı hesaplar için zorunlu hale geldi. Bu tarihten itibaren GA4 entegrasyonu olan hesaplar, tüm raporlama süreçlerini GA4 üzerinden yönetmek zorundadır.GA4 arayüzü Universal Analytics’e göre daha kullanıcı dostu olmasına rağmen, hâlâ birçok raporlama hatası oluşmaktadır. Bu makalede, en yaygın beş GA4 raporlama hatasını ve bunların nasıl düzeltileceğini ele alıyoruz. Eksik Veri Bazen GA4’te hiç veri göremezsiniz. Bu genellikle izleme kodunun yanlış kurulması veya kullanıcının tarayıcısında engellenmesi nedeniyle olur. Çözmek için: GA4’te Property → Data Streams → Web bölümüne gidin ve akışınızın Ölçüm Kimliğini (Measurement ID) kopyalayın. Bu kimliği ya sayfa kaynağınıza doğrudan kodlayarak ya da GTM’e bir “GA4 Configuration” etiketi ekleyerek kurun. Veri Tekrarı Bu genellikle GA4 kodunun hem doğrudan HTML’de hem de GTM üzerinden yüklenmesinden kaynaklanır. Yalnızca bir yöntem kullanın—ya doğrudan HTML’ye ekleyin ya da GTM üzerinden, ikisini birden değil. Veriyi Yanlış Yorumlamak – UA ve GA4 Karşılaştırması Universal Analytics (UA) ve GA4 farklı veri modelleri kullanır (UA: oturum/son tıklama; GA4: etkinlik/son etkileşim) ve farklı kullanım amaçlarına hizmet eder. Raporları yan yana karşılaştırmak kafa karışıklığı yaratır. Bunun yerine: Her metrik ve boyutun kendi bağlamında ne anlama geldiğini öğrenin. Doğrudan karşılaştırma yapmak yerine ihtiyacınıza en uygun aracı seçin. Daha fazla bilgi için bkz.: UA ve GA4 Arasındaki Farklar Atıf Modeli Farkları Son Direkt Olmayan Tıklama: Direkt trafiği görmezden gelir ve son direkt olmayan kaynağa kredi verir. Son Tıklama: Tüm kaynakları kapsar ve en son tıklamayı kredi olarak verir. Geçersiz Veri Filtreleri Çok katı veya yanlış yapılandırılmış filtreler geçerli verileri dışlayabilir. Filtrelerinizi Admin → Data Settings → Data Filters altında kontrol edin ve yalnızca gerçekten istenmeyen trafiği filtrelediğinizden emin olun. Karışık Analiz Arayüzü Binlerce etkinlik ve parametre olduğunda GA4 arayüzü kullanımı zorlaşabilir. Büyük veri kümeleri için GA4–BigQuery bağlantısını etkinleştirin ve karmaşık sorgularınızı BigQuery’de gerçekleştirerek daha güvenilir ve ölçeklenebilir analiz yapın.

Analytics Açıdan Web Sitesi Kurgusu

Bir web sitesinin UX uyumlu olması, Analytics açıdan ölçümlemelerin sağlıklı bir kurguda yapılabilmesi için site tasarımının ve site teknik altyapısının aşağıdaki maddelere uygun bir şekilde kurgulanması gerekmektedir. GTM (Google Tag Manager) kodunun datalayer öncesinde yüklenmesi, veri toplama ve analitik işlemleri için gerekli olan verilerin doğru bir şekilde toplanmasını ve izlenmesini sağlar. Eğer GTM kodu datalayer’den sonra yüklenirse, veri toplama ve analitik işlemleri için gerekli olan verilerin eksik veya yanlış toplanmasına sebebiyet verebilir. Bu nedenle, GTM kodunun datalayer öncesinde yüklenmesi önemlidir. Teknik anlamda sayfa yapısının Single Page olmamasına dikkat edilmelidir. Single Page olan sitelerde Analytics üzerindeki ölçümlemeler ve GTM kurguları daha problemli olmaktadır.Single Page; yani tek sayfalık web siteleri, tüm içeriği tek bir sayfada sunan web siteleridir. Bu tür web sitelerinde, kullanıcılar sayfa içinde kaydırarak içeriği tarama veya arama yaparak aradıkları içeriği bulma gibi işlemleri gerçekleştirirler. Web Sitesinin Neden Single Page Yapısında Olmaması Gerekmektedir? İçerik Yoğunluğu: Eğer bir web sitesinde çok sayıda içerik varsa, tüm içerik tek bir sayfada sıkıştırılmaya çalışıldığında, kullanıcılar içerik arama veya tarama işlemini daha zor hale getirebilirler. Bu nedenle, sayfalar arasında bölünmüş içerik, kullanıcıların kolayca istedikleri içeriği bulmalarına yardımcı olabilir. SEO İyileştirmeleri: Birden fazla sayfadan oluşan bir web sitesi, arama motoru optimizasyonu için daha uygun bir yapıya sahiptir. Her sayfaya özgü meta etiketleri, başlıklar ve açıklamalar kullanarak, her sayfanın arama motorları tarafından daha kolay taranmasını sağlayabilirsiniz. Yükleme Hızı: Tek sayfada çok fazla içerik olduğunda, sayfanın yüklenme süresi artabilir. Bu, kullanıcıların sayfanızı terk etmesine neden olabilir. Sayfalar arasında bölünmüş içerik, yüklenme süresini azaltarak, kullanıcı deneyimini iyileştirebilir. Yönetim Kolaylığı: Birden fazla sayfadan oluşan bir web sitesi, içeriğin daha kolay yönetilmesini sağlar. Tek bir sayfada tüm içeriği yönetmek, zaman alıcı ve zor olabilir. Ancak birden fazla sayfadan oluşan bir web sitesi, içeriği daha organize ederek, içeriği yönetmeyi ve güncellemeyi daha kolay hale getirebilir. İçerik Odaklılık: Birden fazla sayfadan oluşan bir web sitesi, her sayfayı tek bir konuya veya amaç için optimize etmenize olanak tanır. Bu, her sayfanın daha net ve odaklı bir mesaj sunmasına yardımcı olabilir ve kullanıcıların doğru içeriği kolayca bulmalarına olanak tanır. Tabii ki, her web sitesi için farklı gereksinimler vardır ve bazı durumlarda tek sayfadan oluşan bir web sitesi uygun olabilir. Ancak, genel olarak, birden fazla sayfadan oluşan bir web sitesi, içeriği daha iyi organize edebilir, kullanıcı deneyimini iyileştirebilir ve arama motoru optimizasyonu için daha uygun bir yapıya sahip olabilir. Site tasarımında Jakob Yasası çerçevesinde kullanıcıya daha pratik bir deneyim sunulmalıdır. Burada site tasarımcısının tekerleği yeniden icat etmesinden ziyade alışılagelmiş etkileşim kurallarının siteye entegre etmesi ve tasarımı bu yönde iyileştirmesi beklenmektedir. Site konumlandırmasında kullanıcıların ilgisinin header alanında footer alanına doğru azaldığını göz önünde bulundurularak site içerisinde can alıcı conversion rate oranına etki edecek kurguların planlamasının ve konumlandırmasının yapılması oldukça önem verilmesi gereken bir konudur. Site tasarımında menü yapısı içerisinde kategori hiyerarşisine dikkat edilmeli ve UX doğrultusunda kullanıcıya pratik ve hizmet sunmalıdır. Bir sitede kategori hiyerarşisi, içerikleri organize etmek ve kullanıcıların aradıkları içeriği kolayca bulmalarını sağlamak için önemlidir. Kategori hiyerarşisi, içeriklerin birbirleriyle olan ilişkilerini gösterir ve kullanıcılara içeriği bulmak için rehberlik eder. Bir site için doğru kategori hiyerarşisi, kullanıcıların sitenin yapısını daha iyi anlamalarını ve gezinmelerini kolaylaştırır. Örneğin, bir e-ticaret sitesinde kategori hiyerarşisi, ürünleri daha spesifik bir şekilde sınıflandırarak kullanıcılara kolay bir alışveriş deneyimi sunabilir. İçerik yoğun bir haber sitesinde ise, haberlerin konularına göre kategorilere ayrılması ve alt kategorilere bölünmesi, kullanıcıların ilgilendikleri konuları kolayca bulmalarını sağlayabilir. Kategori hiyerarşisi ayrıca, site içi arama motorlarının kullanımını da kolaylaştırabilir. Kullanıcılar, arama sonuçlarında belirli bir kategori altında bulunan içerikleri daha kolay bulabilirler.Sonuç olarak, doğru bir kategori hiyerarşisi, içeriğin daha iyi organize edilmesini sağlar ve kullanıcılara sitenin yapısını daha iyi anlamalarına ve içerikler arasındaki ilişkileri daha iyi anlamalarına yardımcı olur. Kullanıcıların ve arama motorunun siteyi daha iyi anlaması ve kullanabilmesi için alt kategorilerden oluşan breadcrumb yapısı oluşturulmalıdır. Breadcrumb, web sitelerindeki sayfa konumunu gösteren bir navigasyon öğesidir. Breadcrumb, kelime anlamı olarak "ekmek kırıntısı" anlamına gelir ve bir web sitesinde kullanıcının hangi sayfada olduğunu göstermek için kullanılan bir yol belirtecidir.Breadcrumb, genellikle sayfanın üst kısmında veya içeriğin üzerinde birkaç kelime veya kelime öbeği olarak görünür. Bu kelime veya kelime öbekleri, kullanıcının bulunduğu sayfanın konumunu gösterir. Örneğin, bir e-ticaret sitesinde bir kullanıcı "Elektronik" kategorisinde ise, breadcrumb "Anasayfa > Kategoriler > Elektronik" şeklinde görülebilir. Bir sayfanın ideal açılış süresi 2,5 saniyenin altında olması beklenmektedir.. Sayfa hızının Analytics ve CRO açısından önemi oldukça önemlidir. Bu sebeple sitenin teknik anlamda hız çalışmaları dikkate alınarak kurgulanması gerekmektedir. Brandbook içerisinde yer alan marka renkleri ve tipolojisi her alanda vurgulanmalıdır. URL yapıları mümkün olduğunca kısa ve anlamlı olmalıdır. URL sonuna eklenen page path’ler kategori hiyerarşisine göre kurgulanabilir. Bir E-ticaret sitesindeki en doğru kurgu kullanıcının mümkün olan en kısa sürede conversion yolculuğunu başlatmak ve bu yolculuk sırasında kullanıcıya doğru, hızlı ve pratik bir deneyim sunmaktır. Bu bağlamda düşünecek olursak Funnel adımları kısa tutularak kullanıcı doğrudan conversion’a yönlendirilmelidir. Görsel optimizasyon sağlanmalı ve ürün görsellerinin boyutları site hızı kampsamında en fazla 100 KB olmalıdır. Burada banner görselleri boyutları değişiklik gösterebilir. Buna ek olarak görsellerin isimlendirmeleri ve alt text’ler de doğrudan görselle ve sayfayla ilişkili olması durumunda arama motorlarının görsel kısımlarında index olmasını almasını sağlayacaktır. İndirilebilir linkler için (örn: PDF indirmeleri) yeni bir sayfa olarak açılmamalı doğrudan takip açısından indirilebilir döküman formatında kurgulanmalıdır. Mevcut sitelerin search kısımlarında kurgulanan Ghost Search kurgusu önerilmemektedir. Bu durum search term takiplerini ve analizlerini zorlamaktadır. Ghost Search, kullanıcının arama kutusuna yazmadan önce arama sonuçlarını otomatik olarak görüntüleyen bir arama özelliğidir. Bu özellik, kullanıcının aradığı içeriği bulmasına yardımcı olabilir, ancak, ghost search özelliği, bir web sitesinde kullanılmaması gereken bir özelliktir. Bunun nedeni, kullanıcıların arama kutusuna yazmaya başlamadan önce ne aradıklarını tam olarak düşünmeden arama sonuçlarına erişmelerini sağlamasıdır. Bu, yanlış sonuçların veya kullanıcının istediği sonuçlara ulaşamaması gibi problemlere yol açabilir.Ayrıca, ghost search özelliği, web sitesinde kullanılan kaynakları artırabilir ve sayfa yükleme süresini olumsuz etkileyebilir. Ghost search, kullanıcıların siteyi daha fazla kullanmasını sağlamak için tasarlanmış olsa da, site performansına zarar verebilir ve kullanıcı deneyimini olumsuz etkileyebilir.Bunun yerine, web sitelerinde basit ve kullanıcı dostu bir arama özelliği kullanılması daha faydalı olabilir. Bu, kullanıcıların istedikleri sonuçlara daha hızlı ve doğru bir şekilde erişmelerini sağlar ve site performansına olumsuz etkisi olmaz. Click depth (tıklama derinliği), bir kullanıcının az tıklama ile içeriğe ulaşabilmesidir. Burada depth ne kadar artarsa kullanıcının o sayfaya ulaşması zorlaşacak ve bu durum da UX/UI açısından problemlere sebebiyet verecektir. Bu doğrultuda click depth dikkate alınarak site tasarımında iyileştirmeler yapılmalı, mümkün mertebede 2 ya da 3 tıklamanın ötesine geçilmeyecek bir kurgu çalışılmalıdır. Bir e-ticaret sitesinde kullanıcıların site içerisindeki hareketlerinde ( Sepete Ekleme veya Üye Girişi gibi adımlarda) eksik ve hatalı bir aksiyon gerçekleştirmesi durumunda bir uyarı pop-up kurgusu çalışılabilir. Bu kurgu ile olası dead clicklerin önüne geçilecek ve conversion rate doğrudan olumlu etkilenecektir. Banner görsellerine eğer bir listeleme sayfasına yönlendiriyorsa linkleme yapılmalı ve kullanıcının conversion yolculuğu başlatılmalıdır. Ürün sayfalarında conversion rate oranını ve kullanıcının sitedeki etkileşimini arttırabilmek adına ilgili ürünler (önerilerin ürünler, ilginize çekebilecek ürünler) formatında bir slider çalışması yapılmalıdır.

Dijital Dünyada 2023 Trendleri

Dijital dünya, gelişen teknolojiyle birlikte büyümeye ve evrimleşmeye devam ediyor. Google, Meta ve Apple gibi önde gelen teknoloji şirketlerinin yönlendirdiği yeniliklere ayak uydurmak için markaların ve web sitelerinin 2023’ün en son trendlerini takip etmesi ve kendi uygulamalarına entegre etmesi gerekiyor. Bu yazıda, ölçümlerinizi geliştirmenize, trendleri yakalamanıza ve dijital pazarlamada rekabetçi kalmanıza yardımcı olacak 2023’ün temel dijital trendlerini paylaşacağız.2023’te Bizi Neler Bekliyor?2023 yılında dijital pazarlamayı yönlendiren veri ve analitikler daha insana odaklı bir yaklaşıma kayacak ve yapay zekâ ile makine öğrenimi giderek daha belirgin bir rol oynayacak. Veri güvenliğine verilen önem arttıkça, analitik uzmanları da giderek daha kritik sorumluluklar üstlenecek. 2023’te beklediğimiz pratik trendler şunlardır: Daha İnsana Odaklı Dijital Pazarlama: Kişiselleştirilmiş, insan merkezli deneyimler sunmak çok önemli olacak. Pazarlamacılar, müşteri davranışlarını, ilgi alanlarını ve satın alma verilerini kullanarak son derece hedefli kampanyalar oluşturacak. YZ & ML Uygulamalarının Yükselişi: Yapay zekâ ve makine öğrenimi daha yaygın hale gelerek daha derin veri analizleri, daha doğru tahminler ve daha hızlı karar alma süreçleri sağlayacak. Yapay zekâ, pazarlamacıların bireysel ilgi alanlarını ve satın alma davranışlarını anlayarak daha etkili kampanyalar oluşturmasına yardımcı olacak. Veri Güvenliğine Daha Fazla Önem: Artan veri ihlalleri ve siber saldırılarla birlikte şirketler müşteri verilerini korumaya daha fazla yatırım yapacak. GDPR gibi gizlilik düzenlemeleri en iyi uygulamalara yön verecek. Gelişmiş Veri Görselleştirme: Tableau, Looker Studio gibi kapsamlı görselleştirme araçları, hızlı ve içgörülü kararlar almak için her zamankinden daha önemli hale gelecek. IoT Pazarlaması: Nesnelerin İnterneti, cihazdan cihaza veri toplama sayesinde yeni müşteri içgörüleri sağlayacak ve pazarlamacıların ürün ve hizmetlerini daha hassas şekilde uyarlamalarına imkân tanıyacak. 2023’ün teknik ve teorik dijital trendleri şunlardır: Meta – Conversions API (CAPI) Google – Sunucu Taraflı Etiketleme Google – BigQuery ChatGPT UX Yasaları & Nörobilim Teknikleri Meta – Conversions API (CAPI)Conversions API, Meta tarafından pazarlama verileri ile reklam optimizasyonu arasında doğrudan bağlantı kurmak, eylem başına maliyeti düşürmek ve Meta teknolojilerinde ölçümü geliştirmek için tasarlanmıştır. CAPI aracılığıyla web sitesi olaylarını göndermek için Google Cloud Platform’da (GCP) bir sunucu kurar ve yapılandırırsınız, ardından GA4 web etiketi verilerini bu sunucuya ve oradan Meta’ya CAPI aracılığıyla iletirsiniz.Conversions API ile: Markalar eylem başına maliyetlerini düşürür. Kampanyaları optimize etmek daha kolay hale gelir. Kullanıcı verileri doğrudan sunucunuzdan Facebook’un sunucusuna gönderilerek çerezler atlanır ve iOS 14 sonrası gizlilik korunur. Reklam performans ölçümü daha güvenilir hale gelir. CAPI verileri, piksel tabanlı takibe göre hatalara daha az eğilimlidir. Google – Sunucu Taraflı EtiketlemeSunucu Taraflı Etiketleme, ölçüm etiketlerini istemciden (tarayıcı) kontrolünüzdeki bir sunucuya (ör. GCP üzerinde) taşır. Bu yaklaşım, istemci tarafı etiketlemeye göre birkaç avantaj sunar: Sitenizde/uygulamanızda daha az etiket bulunarak ön yüz performansı artar. Kullanıcı verileri müşteri tarafından yönetilen bir sunucu ortamında işlendiği için daha iyi veri koruması sağlanır. GTM aracılığıyla manuel CAPI entegrasyonlarını basitleştirir. Google – BigQuery2012’de Google’ın Dremel teknolojisi üzerinde başlatılan BigQuery, büyük ölçekli hızlı SQL analitiği için kurumsal bir veri ambarıdır. GA4’ün Temmuz 2023’te zorunlu hale gelmesiyle birlikte markaların, verilerini uzun vadeli olarak depolaması, doğru görselleştirmeler yapması ve derin analizler gerçekleştirmesi için BigQuery’ye ihtiyacı olacak.Neden BigQuery? 2023’te güvenli, uzun vadeli veri depolama ve markaya özel gelişmiş analizler kritik önem taşıyor. GA4’ün varsayılan veri saklama süresi yalnızca iki aydır (14 aya kadar uzatılabilir). BigQuery, zaman sınırlamalarını tamamen ortadan kaldırır. Her özel olayı ve parametreyi tek bir tabloda satır sınırı olmadan yakalar. Sütun bazlı depolama ve ağaç mimarisi, devasa veri kümeleri üzerinde son derece hızlı sorgular yapılmasını sağlar. Çevrim içi/çevrim dışı verileri birleştirerek gelişmiş analizler (CLV, kümeleme, birliktelik analizi vb.) yapar ve dahili ML desteği sunar. Kullanıcı kimliği aracılığıyla farklı araçlar ve CRM sistemlerinden gelen verileri birleştirerek çapraz platform ölçümlemeyi destekler. BigQuery’de yapılan derin analizler size örneğin çevrim dışı satın almaları çevrim içi kampanya kitlelerinden hariç tutma olanağı verir, bu da dönüşüm oranlarını artırır.ChatGPTŞüphesiz 2023’ün en çok konuşulan yapay zekâsı ChatGPT oldu. GPT-3.5 tarafından desteklenen bu sohbet yapay zekâsı, gerçek zamanlı, insan benzeri yanıtlar üretebiliyor—hatta kod bile yazabiliyor. Herhangi bir soruyu anlayıp yanıtlayabilme yeteneği, onu yılın en önemli trendlerinden biri haline getiriyor.UX Yasaları & NörobilimNörobilim, sinir sistemini inceleyen bir bilim dalıdır. Fizyoloji, anatomi, matematik, gelişim biyolojisi ve psikolojiyi birleştirerek öğrenme, hafıza, davranış, algı ve bilinci açıklar. UX yasaları ve nörobilim teknikleri, bu ilkeleri web tasarımına entegre ederek daha sezgisel, beyin dostu kullanıcı deneyimleri yaratır. Tasarımınızla etkileşime giren her kullanıcı belirli psikolojik ilkelere göre hareket eder. 2023’te markalar, nörobilimden yararlanarak UX analizlerini bilgilendirecek ve site tasarımlarını insan bilişine göre optimize edecek.Daha fazla bilgi için bkz. UX Yasaları & Nörobilim. Eğer 2023’ün ilk çeyreğinde bu entegrasyonları henüz uygulamadıysanız, hızlı hareket edin—trendi kaçırmayın.

GDPR Nedir, GA4 GDPR Uyumlu Mudur?

Veri gizliliği son yıllarda giderek daha önemli hale geldi. Bunun nedeni, tüketicilerin ve kullanıcıların kişisel verilerini koruma konusundaki endişeleri ve hükümetlerin bu verileri korumak için çeşitli yasalar çıkarmasıdır. Bu yazıda Google Analytics 4’ün (GA4) veri gizliliği özelliklerine odaklanacak ve bu özelliklerin Genel Veri Koruma Tüzüğü’ne (GDPR) uyup uymadığını inceleyeceğiz.GDPR Nedir?GDPR (General Data Protection Regulation – Genel Veri Koruma Tüzüğü), 2018’de yürürlüğe giren bir veri gizliliği düzenlemesidir. Avrupa Birliği’ndeki kuruluşların kişisel verileri nasıl topladığını, işlediğini ve sakladığını düzenler. GDPR, kullanıcı merkezli bir gizlilik yaklaşımı benimseyerek kuruluşların hangi verileri topladıklarını, bunları nasıl kullandıklarını ve kimlerle paylaştıklarını açıklamalarını zorunlu kılar.GDPR Kimleri Kapsar?GDPR, AB ve Avrupa Ekonomik Alanı’nda (EEA) kişisel verilerin işlenmesine yönelik standartlar belirler ve şeffaflık, adillik, amaç sınırlaması, doğruluk, bütünlük ve gizlilik ilkelerini tesis eder.AB veya EEA içinde faaliyet gösteren tüm şirketler, kişisel verileri işlerken GDPR’ye uymak zorundadır. Ayrıca, AB/EEA dışında olup AB/EEA sakinlerinin kişisel verilerini işleyen herhangi bir şirket de GDPR kurallarına uymak zorundadır.Örneğin, AB vatandaşı bir turist olarak Türkiye’yi ziyaret ettiğinde GDPR kapsamı dışında kalır. Ancak AB vatandaşı olmayan bir kişi AB ülkesinde bulunduğunda GDPR tarafından korunur. Eğer bir ABD vatandaşı Almanya’yı ziyaret ederse, Alman kuruluşlarının bu kişinin verilerini GDPR’ye uygun şekilde işlemesi gerekir, birey AB vatandaşı olmasa bile.GDPR Birleşik Krallık’ta Geçerli mi?GDPR, Mayıs 2018’de Birleşik Krallık’ta yürürlüğe girdi. Brexit’ten sonra Birleşik Krallık, GDPR’yi kendi Veri Koruma Yasası’na dahil ederek kişisel veriler için eşdeğer korumaları sürdürdü.Google Analytics’e Karşı Gizlilik Cezalarının GeçmişiGDPR, veri sahiplerine kişisel bilgileri üzerinde daha fazla kontrol sağladı. 25 Mayıs 2018’de yürürlüğe girmesinden bu yana Google, GDPR kapsamında önemli cezalarla karşı karşıya kaldı. Mart 2020’de İsveç, Google LLC’ye, talep üzerine arama sonuçlarını kaldırmadığı için 17(1)(a) maddesini ihlal etmekten 7 milyon € ceza verdi. Ardından Aralık 2021’de Fransa’nın CNIL kurumu, kullanıcıların izleme çerezlerini kabul etmek kadar kolay reddedememesi nedeniyle Google’a 150 milyon € ceza kesti. Google Ireland’a 60 milyon €, Google LLC’ye ise aynı gerekçeyle 90 milyon € ceza verildi.Fransız düzenleyiciler ayrıca GA4’ün IP anonimleştirmesini, verilerin ABD’ye aktarımını korumak için yetersiz buldu. AB Adalet Divanı, Temmuz 2020’de AB-ABD veri transferlerini yöneten Privacy Shield çerçevesini geçersiz kıldı ve bu durum Google’ın AB verilerini ABD sunucularına taşımasını daha da zorlaştırdı.Avusturya, Hollanda ve Norveç’teki diğer veri koruma otoriteleri de Google Analytics’i GDPR’ye aykırı buldu ve cezalar ya da kısıtlamalar getirme tehdidinde bulundu.Kişisel Olarak Tanımlanabilir Bilgi (PII) Nedir?PII, bir bireyi tanımlayabilen her türlü veriyi ifade eder—isim, adres, doğum tarihi, telefon numarası, e-posta, ulusal kimlik, pasaport numarası vb. PII’nin korunması kritik öneme sahiptir çünkü açığa çıkması bir kişinin kimliğini ve kişisel detaylarını ortaya çıkarabilir.GA4’ün Kullanıcı Gizliliği ÖzellikleriGoogle Analytics 4, site sahiplerinin kullanıcı onayını dikkate alırken yine de faydalı içgörüler elde etmelerine olanak tanıyan çeşitli gizlilik odaklı ayarlar sunar. Veri Ayarları altında iki ana alan vardır: Veri Toplama ve Veri Saklama. Hadi bunları inceleyelim.Veri Toplama AyarlarıVeri Toplama’ya şu yoldan erişebilirsiniz: Yönetici > Veri Ayarları > Veri Toplama:Google Signals Google Signals’ı etkinleştirmek, GA4’ün oturum açmış kullanıcıların site/uygulama verilerini Google hesaplarıyla ilişkilendirmesine olanak tanır, tabi ki kullanıcılar reklam kişiselleştirmeye onay verdiyse. Signals, konum, arama, YouTube ve iş ortağı sitelerinden alınan verilerin toplu ve anonim raporlarda kullanılmasını sağlar. Kullanıcılar bunu myactivity.google.com üzerinden yönetebilir.Konum & Cihaz VerileriBu seçenekler açıldığında, Analytics coğrafi ve cihaz bilgilerini toplayabilir ve belirli ülkeleri hariç tutma imkânı sunar.Kullanıcı Verisi Toplama OnayıBurada, sitenizin/uygulamanızın kullanıcıları verilerinin nasıl toplanacağı ve Analytics ile nasıl paylaşılacağı konusunda bilgilendirdiğini ve buna uygun şekilde onaylarını aldığınızı onaylarsınız.Veri Saklama AyarlarıVeri Saklama, kullanıcı düzeyinde ve etkinlik düzeyinde verilerin ne kadar süreyle saklanacağını (2 veya 14 ay) seçmenize olanak tanır. Ayrıca her yeni oturumda kullanıcı verilerini sıfırlayabilirsiniz. Seçiminiz sektörünüzün ihtiyaçlarını ve toplanan bilgilerin hassasiyetini yansıtmalıdır.IP AnonimleştirmeGA4, her kullanıcının IP adresinin son 8 bitini varsayılan olarak anonimleştirir ve anonimleştirmeyi tamamen veri modeline entegre eder. Bu, kullanıcıların gizliliğini korurken analiz için gerekli coğrafi ve cihaz içgörülerini sağlamaya devam eder.Onay ModuKullanıcılar çerez onayını reddettiğinde, Analytics verileriniz eksik olacaktır. Onay Modu, benzer onay vermiş kullanıcılar temelinde bu kullanıcıların davranışlarını modellemek için makine öğrenimini kullanır ve gizliliği korurken raporlarınıza faydalı içgörüler sağlar.GA4’te Sunucu Konumu & Veri Transferi KısıtlamalarıGDPR kapsamında, EEA veya Birleşik Krallık’tan yeterli koruma olmayan yargı bölgelerine kişisel veri aktarımı kısıtlanmıştır. GA4 kullanıcıları, verilerinin nerede saklanacağını seçemez—Google’ın altyapısının büyük bölümü ABD’dedir. Eğer GA4’te AB/BK kişisel verilerini işliyorsanız, uyumlu transfer mekanizmalarının mevcut olduğundan emin olmalı ve çoğu zaman hukuki danışmanlık almanız gerekebilir.

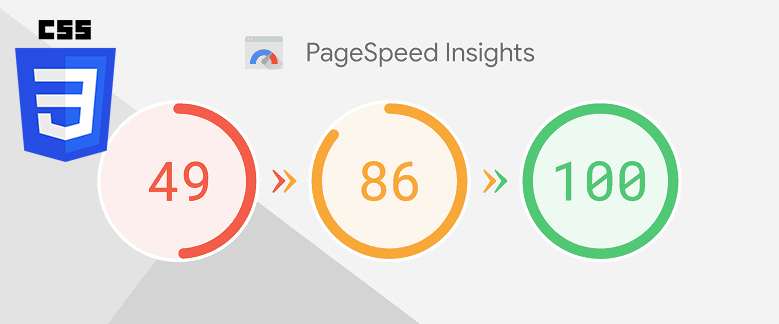

Kullanılmayan CSS ve JS Satırları Nasıl Tespit Edilir?

Web site hızı, SEO çalışmalarındaki en önemli metriklerden bir tanesidir. Günümüzde hemen her arama motoru, web sayfaların hızlı açılması, sayfalardaki DOM boyutunun düşük olması ve minimum düzeyde kaynak tüketimini önemsemektedir. Bu yüzden arama motorları; yavaş açılan, gereksiz kod satırlarıyla dolu, aşırı yüksek boyutta DOM ögeleri kullanan web sayfaları, kullanıcılara başarısız bir sayfa deneyimi sundukları düşünülerek, bu sitelerin üst sıralarda gösterilmekten kaçınırlar.Pagespeed veya GTMetrix gibi ücretsiz hız analiz araçlarıyla yapmış olduğumuz analizlerde, genellikle karşılaştığımız en önemli sorunlar "Kullanılmayan CSS'i Azaltın" ve "Kullanılmayan JavaScript'i Azaltın" uyarıları olmaktadır. Bu uyarılarla ilgili bir aksiyon almadan önce, bu hataların sebeplerini iyi analiz etmeli, web sitemizin alt yapısında barınan CSS ve JavaScript dosyalarının/kütüphanelerin neler olduğunu bilmemiz gerekmektedir.Kullanılmayan CSS'i ve JavaScript'i Azaltın Uyarısı Neden Olur?Genellikle e-ticaret alt yapıları, bünyelerinde hazır CSS ve JavaScript kütüphaneleri barındırmaktadırlar. Bu kütüphaneler, her tip web sitesinde kullanışlı olmak amacıyla yazıldıklarından, içlerinde kullanmadığımız pek çok CSS class'ları ve JavaScript fonksiyonları barındırırlar. Bu dosyalarda yer alan ve web sitemizde kullanmadığımız CSS satırlarını ve JavaScript fonksiyonlarını tespit edip, dosyadan temizleyebilir ve sayfalarımızın daha yüksek performansta açılmasını sağlayabiliriz. Bu satırları tespit etmek için aşağıda paylaştığımız yöntemi sizler de kendi web sitenizde uygulayabilirsiniz!Kullanılmayan CSS ve JavaScript Satırları Nasıl Tespit Edilir?Öncelikle web sitenize giriş yaptıktan sonra, analizini yapmak istediğiniz sayfada sağ tıklayarak "İncele/Inspect" seçeneğine tıklıyoruz.Ardından açılan DevTools panelinin sağ tarafında yer alan üç nokta simgesine tıklayarak More Tools > Coverage seçeneğini aktif hale getiriyoruz.Alt kısımda açılan Coverage panelindeki reload butonuna tıklayarak sayfanın yenilenmesini ve DevTools'un sayfada yer alan CSS ve JavaScript dosyalarını yüklemesini sağlıyoruz.Sayfaya yüklenen CSS/JavaScript dosyalarından herhangi bir tanesine tıklayarak DevTools sekmesinde açılmasını sağlıyoruz.Açılan CSS/JavaScript dosyasında yer alan ve mavi renk ile boyalı kısımlar, ilgili CSS Satırı/JavaScript fonksiyonunun sayfada aktif olarak kullanıldığını, kırmızı renk ile boyalı kısımlar ise kullanılmadığını bizlere göstermektedir.Bu sayede web sitemizin alt yapısında barındırdığı tüm CSS ve JavaScript dosyalarında hangi satır ve fonksiyonların kullanılıp kullanılmadığını rahatlıkla tespit edebiliyoruz.Kullanılmayan CSS ve JS'i Temizlemeden Önce Nelere Dikkat Edilmeli?Her ne kadar web sitemizde barındırdığımız ve sayfaya yüklediğimiz CSS ve JavaScript kütüphanelerinde yer alan kodların bir çoğunu kullanmıyor gibi görünsek de, bu kodlar içerisinde temizlik yapmadan önce dikkat etmemiz gereken bazı noktalar mevcut. Kullanılmayan CSS ve JS temizliği yapmadan önce mutlaka aşağıdaki maddelere dikkat ediniz:İlgili CSS/JS kodunun her tarayıcı, her cihaz ve her sayfada kullanılmadığından emin olun. Bazı JavaScript fonksiyonları belirli event'lere bağlı olarak çalışabilmektedir. Örneğin scroll, click gibi kullanıcı taraflı event'lerle çalışan JavaScript fonksiyonları temizlemeden önce hangilerinin aktif/pasif olduğu iyi analiz edilmelidir. CSS ve JS temizliği yapmadan önce mutlaka tarayıcınızın DOM boyutunu yükselten CSS ve JS dosyalarını ayrıştırın. Küçük boyutlu CSS ve JS dosyalarıyla vakit kaybetmeyin. Optimizasyonları yapmadan önce mutlaka web sitenizin yedeğini almayı unutmayın!Sizler de bu yöntemi kullanarak, web sitenizdeki kullanılmayan CSS ve JavaScript satırlarını tespit edebilir, temizleyebilir ve web sitenizi ziyaret eden kullanıcılara daha performanslı sayfalar gösterebilirsiniz!

Domain Geçmişi Nasıl Kontrol Edilir?

Domain, web sitemizin sahip olduğu alan adına verilen isimdir. Örneğin https://analyticahouse.com web sitesinin sahip olduğu domain/alan adı "analyticahouse.com"dur. Domainler, alan adı kiralayıcıları (hosting/domain firmaları) tarafından belirli bir süreyle kiralanarak kullanılmaktadırlar. Yeni bir web sitesi açmayı düşündüğümüzde veya mevcuttaki web sitemizin geçmişte kullanılıp kullanılmadığını öğrenmek istediğimizde domain geçmişini kontrol etmemiz gerekir. Domain geçmişini kontrol etmek için 2 harika yöntemi sizler için derledik!Domain Geçmişi Neden Önemli?Kullanmakta olduğumuz web sitesinin alan adının/domaininin geçmişte hangi amaçlarla kullanıldığı, herhangi bir arama motoru cezasına maruz kalıp kalmadığını öğrenmek, web sitemizde uygulayacağımız SEO optimizasyonlarında daha bilinçli ve verimli olmamızı sağlayacaktır. Ayrıca web sitemizin geçmişte, Google algoritma güncellemelerinden ne ölçüde etkilendiğini analiz etmek, sitemizde uygulamayı düşündüğümüz SEO çalışmaları için bizlere fikir verecektir. Bu yüzden domain geçmişini kontrol etmek, web sitesinin geçmişte hangi amaçlar için kullanıldığı ve Google algoritmalarından nasıl etkilendiğini bilmek, gelecekte yapacağımız çalışmalara ışık tutacaktır.Domain Geçmişi Nasıl Kontrol Edilir?Domain geçmişini kontrol etmek için videomuzda bahsettiğimiz iki farklı yöntemi uygulayabilirsiniz. Bu yöntemler sayesinde hem domaininizin geçmişte nasıl göründüğü, ne için kullanıldığı hem de Google algoritma güncellemelerinden ne ölçüde etkilendiğini öğrenebilirsiniz. WebArchive İle Domain Geçmişini Kontrol EtmeWeb sitenizin geçmişte nasıl göründüğünü merak ediyorsanız WebArchive web sitesine girerek, sitenizin ana URL'ini yapıştırmanız ve enter'a basmanız yeterlidir. WebArchive bizlere, 1996 yılından bu yana web sitesinin hangi tarihlerde aktif olduğu ve aldığı snapshot'ları gösteren bir kronolojik bar sunmaktadır.Bu kısımdan domaininizin aktif olduğu bir yılı seçerek, aşağıda yer alan takvimden kayıtlı olan snapshot'lara tıklayarak domaininizin o tarihte nasıl göründüğünü, ne amaçla kullanıldığını öğrenebilirsiniz!Website Penalty Indicator İle Domainin Google Algoritma Güncellemelerinden Nasıl Etkilendiğini ÖğrenmeSahip olduğumuz alan adının/domainin, geçmiş Google algoritma güncellemelerinden ne ölçüde etkilendiğini, herhangi bir ceza alarak indekslerini/SEO görünürlüklerini kaybedip kaybetmediğini öğrenmek için Website Penalty Indicator aracını kullanabilirsiniz.Web sitesine giriş yaptıktan sonra alan adınızı yazmanız ve ülkenize ait Google uzantısını seçmeniz yeterlidir. Ardından "check domain" diyerek alan adının geçmişteki Google algoritma güncellemelerinden nasıl etkilendiğini görebilirsiniz.Website Penalty Indicator aracı tamamen ücretsiz bir araç olup, web sitenizin Google algoritma güncellemelerinden nasıl etkilendiğini sizlerle paylaşır. Daha ayrıntılı incelemek ve bu algoritma güncellemelerinin hangileri olduğu hakkında bilgi almak için, ücretli bir araç olan SearchMetrics aracını da kullanabilirsiniz.Domaininizi geçmişte etkilemiş olabilecek Google algoritma güncellemelerini ve değişikliklerini detaylıca öğrenmek için Geçmişten Günümüze Google Algoritma Güncellemeleri başlıklı blog yazımıza göz atabilirsiniz!