Pazarlama İpuçları, Gündem ve Daha Fazlası

AnalyticaHouse’un güçlü iş ortaklıklarından beslenen deneyimi ile güncel trendler, stratejik içgörüler ve sektörel derinlik içeren blog yazılarımızı keşfedin.

SEO ve İçerik Manzarasında Yapay Zekanın Rolü

Yapay zeka (AI), görsel algı, konuşma tanıma, karar verme ve dil çevirisi gibi normalde insan zekâsı gerektiren görevleri yerine getirebilen bilgisayar sistemlerinin geliştirilmesidir. Açıkça programlanmadan, AI sistemleri eğitildikleri verilere dayanarak kendi başlarına öğrenmek ve karar vermek üzere tasarlanmıştır. Yapay zekanın amacı, insan zekâsını simüle edebilen ve daha önce yalnızca insana özgü olduğu düşünülen görevleri yerine getirebilen sistemler geliştirmektir.Yapay zeka, çeşitli görevleri otomatikleştirerek ve daha önce erişilemeyen içgörüler sağlayarak SEO alanını dönüştürüyor. Anahtar kelime araştırması, içerik oluşturma ve optimizasyonu, link inşası ve diğer SEO ve içerik ile ilgili görevlerin tümü yapay zeka araçlarıyla gerçekleştirilmektedir. Bu araçlar, SEO uzmanlarının zaman ve emekten tasarruf etmesini sağlarken daha doğru sonuçlar sunar. Gelin yapay zekanın SEO ve içerik görevlerinde nasıl kullanılabileceğine ve bu alandaki geleceğine daha yakından bakalım.Anahtar Kelime Araştırmasında Yapay ZekaAnahtar kelime araştırmasında yapay zeka, bir web sitesinin hedeflemesi gereken en alakalı ve kârlı anahtar kelimeleri belirlemek için kullanılır. Yapay zeka araçları, arama hacimleri, rekabet seviyeleri ve kullanıcı davranış kalıpları gibi büyük miktarda veriyi analiz ederek en uygun anahtar kelimeleri belirlemeye yardımcı olabilir. Bu, SEO uzmanlarına hedef kitlelerini ve onların ilgili ürün ve hizmetleri bulmak için kullandıkları anahtar kelimeleri daha iyi anlama imkânı verir. Yapay zeka, bir web sitesindeki içerikleri, rakip siteleri ve diğer kaynakları analiz ederek anahtar kelime önerileri sunabilir ve yeni anahtar kelime fırsatlarını belirleyebilir. AI algoritmaları, anahtar kelimelerin alaka düzeyini ve bağlamını değerlendirebilir, seçilen anahtar kelimelerin web sitesinin genel teması ve hedefleriyle uyumlu olmasını sağlar. Yapay zeka, anahtar kelime araştırmasını devrim niteliğinde değiştirerek web sitelerinin optimizasyonuna ve arama sıralamalarına yardımcı olacak daha doğru ve uygulanabilir içgörüler sağlar.Anahtar Kelime Araştırmasında Yapay Zeka Kullanmanın AvantajlarıAnahtar kelime araştırmasında yapay zeka kullanımı, daha doğru, daha hızlı ve maliyet açısından verimli sonuçlar sağlayarak web sitesi optimizasyonunun ve arama sıralamalarının iyileştirilmesine yardımcı olur. Yapay zeka şunları yapabilir: Büyük miktarda veriyi analiz ederek seçilen anahtar kelimelerin son derece alakalı ve doğru olmasını sağlar, Çok büyük veri setlerini saniyeler içinde işleyerek zaman ve emekten tasarruf sağlar, Kullanıcı davranış kalıplarını analiz ederek hedef kitlenin kullandığı anahtar kelimeleri ve ifadeleri anlamaya yardımcı olur, Her anahtar kelimenin rekabet seviyelerini analiz ederek daha az rekabetli ve daha kârlı kelimeleri belirler, Yeni anahtar kelime önerileri sunar ve gözden kaçmış olabilecek fırsatları ortaya çıkarır, Kullanıcının konumu, arama geçmişi ve diğer faktörlere göre kişiselleştirilmiş anahtar kelime sonuçları sunar, böylece sonuçlar daha alakalı ve değerli olur. Liste uzatılabilir. Ancak burada tüm avantajları listeleyemeyiz çünkü bu sadece başlangıç ve okumaya devam ettikçe göreceğiniz üzere bu liste gelecekte çok daha uzun olacaktır.Anahtar Kelime Araştırması için Yapay Zeka Araçlarına ÖrneklerEn popüler anahtar kelime planlama araçları aslında fikir üretmek için yapay zekadan yararlanır. Anahtar kelime planlama söz konusu olduğunda akla gelen ilk SEO araçlarından bazıları şunlardır:SEMrushSEMrush, anahtar kelime araştırması, site denetimi, rakip analizi ve diğer görevleri gerçekleştirmek için yapay zeka algoritmalarını kullanan hepsi bir arada dijital pazarlama aracıdır. Arama hacmi, rekabet, trend analizi ve uzun kuyruklu kelime önerileri gibi ayrıntılı anahtar kelime verileri sunar. SEMrush yalnızca araştırma veya yazım aşamasında değil, içerik planlamasında da destek sağlar. Kendi makine öğrenimi algoritmalarıyla SEMrush, kullanıcılarına popüler ve SEO dostu içerik konuları önerir. Tek yapmanız gereken bir konu tanımlamaktır. Geri kalanını yapay zeka teknolojisi halleder. Konunuzu tanımladıktan sonra araç size farklı konu grupları ve her grup için 3’ten fazla içerik fikri sunar. AhrefsSEMrush ile benzer ve farklı özelliklere sahip olan Ahrefs, yapay zeka algoritmaları kullanarak anahtar kelime araştırması ve analizi yapan popüler bir SEO aracıdır. Arama hacmi, tıklama başı maliyet, anahtar kelime zorluğu gibi veriler sağlar ve yeni anahtar kelime önerileri sunar. Bu, çok büyük veri setlerinin yönetilmesi anlamına gelir. SEMrush gibi Ahrefs de yapay zekadan faydalanır.Google Keyword PlannerGoogle Keyword Planner, Google’ın ücretsiz anahtar kelime araştırma aracıdır. Yapay zeka algoritmalarını kullanarak anahtar kelime popülerliği, rekabet seviyeleri ve tahmini tıklama başı maliyet hakkında bilgi sağlar. Ayrıca ilgili anahtar kelimeler ve ifadeler önerir.İçerik Oluşturma ve Optimizasyonunda Yapay ZekaYapay zeka, yüksek kaliteli, alakalı ve ilgi çekici içerik oluşturmaya yardımcı olmak için içerik oluşturma ve optimizasyonunda kullanılıyor. Yapay zeka algoritmaları, arama motoru sonuçları, sosyal medya trendleri ve kullanıcı davranış kalıpları gibi devasa veri setlerini analiz ederek belirli bir kitle için en alakalı ve değerli konu, anahtar kelime ve ifadeleri belirlemeye yardımcı olabilir.İçerik Oluşturma ve Optimizasyonunda Yapay Zeka Kullanmanın AvantajlarıAşağıda yapay zekanın içerik oluşturma ve optimizasyonunda kullanılmasının bazı avantajları yer almaktadır: Yazmadan önce bilgi toplayarak konu hakkında makaleler bulmak, Kullanıcı davranışları, arama motoru sonuçları ve sosyal medya trendlerini analiz ederek en alakalı konuları belirlemek, Yeni, özgün ve ilgi çekici içerikler oluşturmaya yardımcı olarak daha fazla yaratıcılık ve çeşitlilik sağlamak, Konum, arama geçmişi ve diğer faktörlere göre kişiselleştirilmiş içerik önerileri sunarak doğru hedef kitleye ulaşmak, Mevcut içerikleri analiz ederek optimizasyon önerileri sunmak ve içeriklerin SERP’lerde görünürlüğünü ve sıralamasını artırmak. Backlink Oluşturmada Yapay ZekaYapay zeka, yüksek kaliteli, alakalı ve otoriter backlink’lerin oluşturulmasına ve yönetilmesine yardımcı olmak için backlink stratejilerinde kullanılır. Yapay zeka algoritmaları, arama motoru sonuçları, sosyal medya trendleri ve kullanıcı davranışlarını analiz ederek hedef kitle için en değerli ve alakalı siteleri ve sayfaları belirleyebilir.Yapay zeka ayrıca backlink inşasında her bağlantının rekabet seviyelerini analiz ederek de yardımcı olabilir. Bu, misafir yazı yazılabilecek yeni siteler bulmayı, bozuk bağlantıları tespit edip değiştirmeyi ve backlink için yeni sitelerle iletişime geçmeyi içerebilir.Backlink İçin Yapay Zeka Araçlarına ÖrneklerBacklink oluşturma için Ahrefs ve SEMrush gibi kapsamlı yapay zeka destekli SEO araçları kullanılabilir. Ancak backlink odaklı araçlarda da yapay zeka teknolojisinden yararlanılmaktadır.MajesticMajestic, backlink analizi yapan bir araçtır ve backlink’leri yapay zeka algoritmalarıyla analiz ederek kategorize eder. Backlink gücü, bağlantı kalitesi ve alaka düzeyi hakkında bilgi sağlar ve yeni bağlantı fırsatları sunar. Bu verileri sağlamak için yapay zekaya dayanır.BuzzStreamBuzzStream, backlink oluşturma ve iletişim yönetimi aracıdır. İletişim bilgilerini bulma, e-postalar gönderme ve yanıtları takip etme gibi tekrar eden görevleri otomatikleştirir. Backlink oluşturma sürecini kolaylaştırır ve sonuçları iyileştirir.SEO ve İçerikte Yapay Zekanın GeleceğiYapay zekanın anahtar kelime planlama, içerik planlama ve yazma, backlink optimizasyonu ve SEO dışındaki birçok kullanımını göz önünde bulundurduğumuzda, yakın gelecekte yapay zekanın: Kullanıcılar için arama deneyimini daha kişiselleştirilmiş, alakalı, faydalı ve değerli hale getirmede daha büyük rol oynaması, Sesi arama teknolojisini daha doğru, hızlı ve duyarlı hale getirerek kullanıcı deneyimini iyileştirmesi, Daha da gelişerek büyük miktarda veriyi gerçek zamanlı olarak analiz edebilecek kadar sofistike bir hâle gelmesi, Daha öngörücü hâle gelerek içeriklerde kullanılacak en iyi konular, anahtar kelimeler ve ifadeleri belirlemesi ve en etkili optimizasyon stratejilerini önermesi, Daha fazla SEO görevini otomatikleştirerek manuel çabayı azaltması ve doğruluğu ile verimliliği artırması, İçerik oluşturma sürecinde daha önemli bir rol oynaması, yeni, özgün ve ilgi çekici içerikler üretmeye yardımcı olması, Ve sanal ile artırılmış gerçeklikte daha büyük bir rol oynayarak kullanıcı deneyimini geliştirmesi, daha etkileşimli ve sürükleyici içerikler yaratması beklenmektedir. Yapay Zeka İnsan Yazarların Yerini Alacak mı?Bu soru son zamanlarda sık sık soruluyor. Aslında makinelerin, bu bağlamda yapay zekanın, insan işlerini devralacağı düşüncesi yeni değil. Dolayısıyla şu anda insanların işlerini kolaylaştırmak için kullanılan yapay zekanın gelişerek işleri tamamen devralacağı fikri normal. Bu soruya yapay zekadan faydalanan tüm alanlar için net bir yanıt vermek zor. Ama bu soruya içerik dünyası özelinde bakalım.İçerik üretimi söz konusu olduğunda, yapay zeka raporlar, haber metinleri ve ürün açıklamaları gibi nispeten düz ve fazla yaratıcılık gerektirmeyen görevler için daha uygundur. Ancak bu araçlardan en iyi çıktıyı alabilmek için hâlâ insanın yönlendirmesine ihtiyaç vardır; yani yapay zekaya hangi tonda, hangi kelimelerle, hangi uzunlukta ve hangi kriterlerle metin üretmesi gerektiğini yazar ya da yönlendiren kişi belirler.Kısacası, yapay zeka metin üretiminde son derece güçlü bir araç olsa da özellikle daha yaratıcı ve öznel yazı türlerinde insan yazarların yerini tamamen alması yakın zamanda pek olası değildir. Yine de konu yapay zekaysa asla asla dememek gerekir.Kaynaklar Search Engine Land – Yapay Zeka SEO’nun Geleceğini Nasıl Değiştirecek RockContent – SEO’da Yapay Zeka Keyword Country – Anahtar Kelime Araştırmasında Yapay Zeka Search Engine Land – Link Oluşturmada Yapay Zekayı Kullanma Convince & Convert – SEO’nun Geleceği Search Engine Journal – SEO için Yapay Zeka

Blog Yazılarında Başlık Hiyerarşisi Nasıl Oluşturulur?

“Bir sayfadaki metin söz konusu olduğunda, bir başlık gerçekten güçlü bir sinyaldir; bu bölümün bu konu hakkında olduğunu bize söyler.”[1] diyor Google Arama Savunucusu John Mueller. Ve haklı, ama dahası da var: Bir başlık yalnızca bize değil, aynı zamanda arama motorlarına da içeriğin konusunu iletir; bu da arama motoru sonuç sayfalarının üst sıralarında görme olasılığımızı belirler.Açık bir başlık-alt başlık hiyerarşisi bir blog yazısında birkaç nedenle önemlidir. Öncelikle, içeriğin okuyucu için okunmasını ve anlaşılmasını kolaylaştırır. İyi yapılandırılmış bir başlık-alt başlık hiyerarşisi, içeriği daha küçük bölümlere ayırarak okuyucunun aradığı bilgiyi bulmasını ve yazının akışını takip etmesini kolaylaştırır. Ayrıca, arama motorlarının içeriği taramasına ve blog yazısının yapısını anlamasına yardımcı olur, bu da daha iyi arama motoru optimizasyonu (SEO) ve arama sonuçlarında daha fazla görünürlük sağlayabilir.Başlık-Alt Başlık Hiyerarşisi Nedir?Bir blog yazısı gibi yazılı bir belgedeki başlıkların ve alt başlıkların hiyerarşisi, içeriği bölümlere ayırmak ve okuyucuların anlamasını kolaylaştırmak için nasıl düzenlendiğini ifade eder.BaşlıkBir belgedeki ana içerik bölümleri, her bölümde ele alınan konuların genel bir görünümünü sağlayan ana başlıklardır. Ana başlıkların amacı, içeriği yapılandırmak ve düzenlemek, okuyucuların belgenin akışını takip etmesini ve aradığı bilgiyi bulmasını kolaylaştırmaktır. Ayrıca arama motorlarının belgenin yapısını anlamasına yardımcı olurlar, bu da görünürlüğünü artırabilir. Kısacası, ana başlıklar başlık-alt başlık hiyerarşisinin önemli bir parçasıdır ve bir belgenin okunabilirliğini, düzenini ve bulunabilirliğini geliştirmede kritik rol oynar.Alt BaşlıklarAlt başlıklar, bir belgenin içeriğinde ana başlıklara ek ayrıntı ve yapı sağlayan ikincil bölümlerdir. Genellikle ana başlıklarla aynı şekilde biçimlendirilirler, ancak daha küçük bir yazı tipi veya daha hafif bir ağırlıkla. Alt başlıklar, içeriği daha küçük ve yönetilebilir bölümlere ayırmak için kullanılır, bu da okuyucuların çeşitli bilgi parçaları arasındaki ilişkileri anlamasını kolaylaştırır.Doğru Başlık-Alt Başlık Hiyerarşisini KurmakAçık bir başlık-alt başlık hiyerarşisi oluşturmak, bir belgenin yapısının dikkatli bir şekilde planlanmasını ve organize edilmesini gerektirir. Bunun için yazarın metnin kabaca bir taslağını oluşturması, metni anlamlı parçalara ayırmayı bilmesi ve alt başlıklara dahil edilecek uygun ifadeleri belirlemesi gerekir. Şimdi iyi organize edilmiş bir blog için neler yapılması gerektiğine daha yakından bakalım.Yazmadan ÖnceYazmaya başlamadan önce, blog yazınızın yapısını tanımlamak, başlık ve alt başlıkların düzenli olmasını sağlamak için kritik öneme sahiptir. Bu aşama, ele almak istediğiniz ana konuların ana hatlarını belirlemeyi ve içeriği faydalı bölümlere ayırmayı içerir. Yazmaya başlamadan önce şu adımları gözden geçirdiğinizden emin olun: Şu soruları yanıtlayın: Vermek istediğiniz temel mesaj veya ana fikir nedir? Okuyucularınızın bu yazıdan ne öğrenmesini veya almasını istiyorsunuz? Kapsamak istediğiniz ana konuları belirleyin ve içeriğinizin temel amacına hangi konu veya alt konuların uygun olduğuna karar verin. Yapının mantıklı ve kolay takip edilir olmasını sağlayın: Başlıkların ve alt başlıkların mantıklı bir ilerleme izlemesini ve içeriğin okuyucuların kolayca anlayabileceği bölümlere ayrılmasını sağlayın. Ana bölümler için h2, daha küçük bölümler için h3, h4 vb. kullanın. Açık ve tutarlı bir başlık-alt başlık biçimlendirmesi kullanmak, iyi bir hiyerarşi kurmak için önemlidir. Biçimlendirme, gövde metninden görsel olarak ayırt edilebilir ve belgenin tamamında tutarlı olmalıdır; böylece okuyucular başlıkları hızlıca fark edip yapıyı takip edebilir.Tüm başlık ve alt başlıklar için aynı yazı tipi boyutu, kalınlığı ve stilini kullanın: Tutarlılık önemlidir, bu yüzden belgenin tamamında aynı biçimlendirmeyi koruyun.Doğru HTML Etiketlerini KullanmakHTML’de başlıklar farklı seviye etiketlerle tanımlanır: h1, h2, h3 vb. Blog yazınızda başlık-alt başlık hiyerarşisini kurmak için doğru etiketi kullanmanız çok önemlidir. h1 etiketi: Bu etiket blog yazınızın ana başlığı için ayrılmıştır ve sayfada yalnızca bir kez kullanılmalıdır. h2 etiketi: Bu etiket yazınızın ana bölümleri için kullanılır. İçeriği ana bölümlere ayıran başlıklar için h2 etiketlerini kullanın. h3, h4 vb.: Bu etiketler içeriği daha küçük alt bölümlere ayırmak için kullanılır. İlk alt başlık seviyesi için h3, sonraki için h4 kullanın ve böyle devam edin. Başlıkların Alaka DüzeyiBaşlıkların ve alt başlıkların, özetledikleri içeriğin amacı ve kavramıyla uyumlu olması kritik öneme sahiptir. Başlıklar ve alt başlıklar, içeriği doğru bir şekilde yansıtmalı ve okuyucunun mantıklı bir şekilde gezinmesine yardımcı olmalıdır.Yazar, gövde metninde ifade edilen fikri birkaç kelimeyle aktarmalı ve bu kelimeleri alt başlığa dahil etmelidir. Ayrıca hem başlıkta hem de alt başlıklarda anahtar kelimeler kullanılmalıdır.Başlık Hiyerarşisi ve SEODüzensiz, fikir akışı eksik olan içeriklere kıyasla iyi organize edilmiş bir blog yazısı, Google’ın tercih ettiği ve kullanıcılara sunduğu içerik türüdür. Çünkü başlıklar ve alt başlıklar yalnızca kullanıcılara değil, aynı zamanda arama motorlarına da içeriğin neyle ilgili olduğunu okumada ve anlamada yardımcı olur. Bu yüzden, kötü organize edilmiş bir blog yazısının SERP’te üst sıralarda yer alması şaşırtıcı değildir. Googlebot içeriği mantıksal akış ve okunabilirlik açısından yararsız bulursa, içerik arama sonuçlarında üst sıralarda listelenmez.Başlıklarda ve Alt Başlıklarda Anahtar KelimelerKullanıcıların ve arama motorlarının içeriği anlamasını kolaylaştıran kritik faktörlerden biri, alt başlıklarda anahtar kelime kullanımının doğru yapılmasıdır. Anahtar kelimeler, yalnızca gövde metinlerinde değil, başlıklarda ve alt başlıklarda da içerik yazarlarının kullanımına sunulmuştur.Kaynaklar Search Engine Journal – On-Page SEO: Header Tags SEO Buddy – Headings and Subheadings ContentKing – Headings Guide Yoast – How to Use Headings on Your Site

Tabakların Kırılma Direnci

Lorem ipsum dolor sit amet, consectetur adipiscing elit, sed do eiusmod tempor incididunt ut labore et dolore magna aliqua. Mauris vitae ultricies leo integer malesuada nunc vel risus. Auctor eu augue ut lectus arcu bibendum at varius vel. Scelerisque purus semper eget duis at tellus. Platea dictumst vestibulum rhoncus est pellentesque. Tellus elementum sagittis vitae et leo duis ut diam quam. Aliquet porttitor lacus luctus accumsan tortor posuere. Nisl pretium fusce id velit ut. Quis eleifend quam adipiscing vitae proin. Hac habitasse platea dictumst vestibulum rhoncus est pellentesque elit. Ut faucibus pulvinar elementum integer enim neque. Hendrerit dolor magna eget est lorem ipsum dolor. Curabitur gravida arcu ac tortor dignissim convallis aenean et. Blog Demo İçerik Başlık 2 Et tortor at risus viverra. Eget nunc scelerisque viverra mauris in aliquam. Sed pulvinar proin gravida hendrerit lectus. Enim sit amet venenatis urna cursus. Leo vel fringilla est ullamcorper eget nulla facilisi etiam dignissim. Ac odio tempor orci dapibus ultrices in iaculis nunc sed. Augue neque gravida in fermentum et. Viverra aliquet eget sit amet tellus cras. Porta nibh venenatis cras sed felis. Elit ullamcorper dignissim cras tincidunt. Duis at tellus at urna condimentum mattis pellentesque. Felis donec et odio pellentesque diam volutpat commodo sed. Blog Demo İçerik Başlık 3 Pharetra sit amet aliquam id diam maecenas. Auctor eu augue ut lectus. Nisi porta lorem mollis aliquam ut. Purus faucibus ornare suspendisse sed nisi lacus sed viverra tellus. Euismod nisi porta lorem mollis aliquam ut porttitor. Etiam tempor orci eu lobortis elementum nibh tellus molestie nunc. Consequat ac felis donec et. Vivamus at augue eget arcu dictum varius duis at consectetur. Nunc non blandit massa enim nec. Tristique risus nec feugiat in fermentum posuere urna nec tincidunt. At erat pellentesque adipiscing commodo elit at imperdiet. Sit amet justo donec enim. A lacus vestibulum sed Blog Demo İçerik Başlık 2 Diam sollicitudin tempor id eu nisl nunc mi ipsum faucibus. Elit pellentesque habitant morbi tristique senectus et netus et. Quam lacus suspendisse faucibus interdum. Nisi porta lorem mollis aliquam ut porttitor leo a diam. Habitasse platea dictumst vestibulum rhoncus. Fermentum iaculis eu non diam phasellus vestibulum. Sollicitudin nibh sit amet commodo nulla. Fames ac turpis egestas integer. Amet cursus sit amet dictum sit amet justo. Massa placerat duis ultricies lacus sed turpis tincidunt id aliquet. Sagittis eu volutpat odio facilisis mauris. Tincidunt ornare massa eget egestas purus viverra accumsan in nisl.

Youtube SEO: Video Arama Sıralamanızı İpuçları

What is Lorem Ipsum? Lorem Ipsum is simply dummy text of the printing and typesetting industry. Lorem Ipsum has been the industry's standard dummy text ever since the 1500s, when an unknown printer took a galley of type and scrambled it to make a type specimen book. It has survived not only five centuries, but also the leap into electronic typesetting, remaining essentially unchanged. It was popularised in the 1960s with the release of Letraset sheets containing Lorem Ipsum passages, and more recently with desktop publishing software like Aldus PageMaker including versions of Lorem Ipsum. Why do we use it? It is a long established fact that a reader will be distracted by the readable content of a page when looking at its layout. The point of using Lorem Ipsum is that it has a more-or-less normal distribution of letters, as opposed to using 'Content here, content here', making it look like readable English. Many desktop publishing packages and web page editors now use Lorem Ipsum as their default model text, and a search for 'lorem ipsum' will uncover many web sites still in their infancy. Various versions have evolved over the years, sometimes by accident, sometimes on purpose (injected humour and the like). Where does it come from? Contrary to popular belief, Lorem Ipsum is not simply random text. It has roots in a piece of classical Latin literature from 45 BC, making it over 2000 years old. Richard McClintock, a Latin professor at Hampden-Sydney College in Virginia, looked up one of the more obscure Latin words, consectetur, from a Lorem Ipsum passage, and going through the cites of the word in classical literature, discovered the undoubtable source. Lorem Ipsum comes from sections 1.10.32 and 1.10.33 of "de Finibus Bonorum et Malorum" (The Extremes of Good and Evil) by Cicero, written in 45 BC. This book is a treatise on the theory of ethics, very popular during the Renaissance. The first line of Lorem Ipsum, "Lorem ipsum dolor sit amet..", comes from a line in section 1.10.32. The standard chunk of Lorem Ipsum used since the 1500s is reproduced below for those interested. Sections 1.10.32 and 1.10.33 from "de Finibus Bonorum et Malorum" by Cicero are also reproduced in their exact original form, accompanied by English versions from the 1914 translation by H. Rackham. Where can I get some? There are many variations of passages of Lorem Ipsum available, but the majority have suffered alteration in some form, by injected humour, or randomised words which don't look even slightly believable. If you are going to use a passage of Lorem Ipsum, you need to be sure there isn't anything embarrassing hidden in the middle of text. All the Lorem Ipsum generators on the Internet tend to repeat predefined chunks as necessary, making this the first true generator on the Internet. It uses a dictionary of over 200 Latin words, combined with a handful of model sentence structures, to generate Lorem Ipsum which looks reasonable. The generated Lorem Ipsum is therefore always free from repetition, injected humour, or non-characteristic words etc.

Youtube SEO: Video Arama Sıralamanızı Yükseltecek İpuçları

YouTube SEO, genellikle YouTube’da videolarınızın ve kanalınızın ilgili konularda sıralamasını iyileştirmeye yönelik optimizasyon sürecini ifade eder. YouTube, dünyanın en çok kullanılan ikinci arama motorudur. Tüm arama motorları gibi bu platformun da kendi karmaşık algoritması vardır. Video içeriklerini optimize ederek, YouTube üzerinden elde edilen abone sayısı, web sitesi ziyaretleri ve kanal bilinirliği (marka) gibi önemli metrikleri artırmayı hedeflersiniz.Tüm arama motoru sıralama algoritmalarında olduğu gibi, YouTube’un sıralama algoritmalarını kimse tam olarak bilmez. Kanal sayfanızı, oynatma listelerinizi, meta verilerinizi, video açıklamalarınızı ve diğer önemli metriklerinizi optimize etmelisiniz. YouTube kanalınızdaki videoları optimize ederek, Google, Yandex ve Bing gibi diğer arama motorlarında da görünürlüğünüzü artırırsınız.YouTube SEO Nedir?YouTube SEO’nun ne olduğunu ve nasıl uygulanacağını incelemeden önce, kısaca SEO’dan bahsedelim. SEO’ya yeniyseniz okumaya devam edin!SEO’nun birçok tanımı vardır, ancak SEO’daki amacımız, bir web sayfasının (arama motorları tüm siteyi değil, tek tek sayfaları sıralar) arama motoru sonuç sayfalarındaki sıralamasını iyileştirmek ve böylece siteye kaliteli trafik ve dönüşüm sağlamaktır.Arama motorları, bir kullanıcının sorgusuna en uygun sonuçları göstermek için web sitelerindeki ve sayfalardaki bilgileri değerlendirir.Web arama motorları, kullanıcılara alakalı içerikler göstermek için kendilerine ait algoritmaları kullanır. Benzer şekilde sosyal medya platformlarının da kendi iç algoritmaları vardır.YouTube, platformunda videoları gösterirken farklı algoritmalar kullanır. Bu nedenle, kanalınızdaki videoların daha fazla kullanıcıya gösterilmesi için YouTube SEO yapmanız gerekir.YouTube SEO Nasıl Yapılır?YouTube için SEO yaparken, her zaman videonuzun metnini yani transkriptini kullanmalısınız. Hedef anahtar kelimeleri transkriptte doğal bir şekilde dahil etmek, SERP’lerde sıralamanıza önemli ölçüde yardımcı olur. YouTube SEO için anahtar kelime seçerken kapsamlı araştırma yapın ve bunları video optimizasyonunuza doğal şekilde ekleyin.Videolarınızın sıralama potansiyelini artırmak için YouTube SEO ipuçları şunlardır: Önemli hedef anahtar kelimelerinizi video başlıklarında ve açıklamalarında kullanın, Mümkünse videolarınıza altyazı ekleyin ve konuşmanızda anahtar kelimelere yer verin, Videolarınızda metin bindirmeleri (text overlay) kullanıyorsanız, anahtar kelimelerinizi açıkça ekleyin, Kanalınıza ilgili videoları kart olarak eklemeyi düşünün, Videonuz için en alakalı kategoriyi seçtiğinizden emin olun, Özel küçük resimler (thumbnail) kullanın ve anahtar kelimeleri görsel dosya adlarına ekleyin, Videolarınıza etiketler ekleyin ve anahtar kelimelerinizi dahil edin, Videolarınıza bağlantılar ve CTA’lar (harekete geçirici mesajlar) ekleyin, YouTube için içerik konusu seçerken Google Trends verilerini inceleyin. YouTube SEO’nun Mantığı Nedir?9 Ekim 2006’da Google, o zamanlar bir video platformu olan ve bugün dünyanın ikinci en popüler arama motoru haline gelen YouTube’u satın aldı.Google, YouTube, Bing, Yandex ve diğer tüm arama motorlarının ortak bir hedefi vardır: Kullanıcılarına mümkün olan en iyi arama deneyimini sunmak.Örneğin, YouTube’da “SEO’nun Evrimi” aradığınızı düşünün. YouTube’un botları, kullanıcıya en uygun sonucu göstermek için platformdaki tüm kanalları ve videoları tarar.Bu botlar en iyi sonuçları gösterebilmek için çeşitli faktörleri dikkate alır.Botlar, iyi bir kullanıcı deneyimi sağlayan videoları belirlemek için farklı algoritmik senaryoları test edebilir.Başlığı, etiketleri, açıklaması ve meta verileri doldurulmuş bir video, bunlara sahip olmayan bir videoya göre daha üst sıralarda yer alabilir. Yeterli yoruma ve etkileşime sahip videolar, başlığı veya etkileşimi olmayanlardan genellikle daha üstte sıralanır.Temel mantık, algoritmanın hangi içeriğin en iyi kullanıcı deneyimini sunacağını tahmin etmesi ve bunu geçmiş aramalar ve beğenilere göre sunmasıdır.YouTube SEO çalışmalarınız, videolarınızın yalnızca YouTube’da değil, aynı zamanda Google’ın video arama sonuçlarında da sıralanmasına yardımcı olur.YouTube SEO İpuçlarıyla Video Sıralamalarınızı ArtırınYouTube ve Google gibi platformların tüm SEO yönergelerine uysanız bile, karmaşık algoritmik hesaplamalar sıralamanızı etkileyebilir.Videolarınızı arama sonuçlarında yükseltmek için YouTube SEO ipuçlarını inceleyelim.Anahtar Kelime AraştırmasıDoğru anahtar kelimeleri seçmek ve kullanmak, Google, YouTube, diğer arama motorları ve web siteleri için kritik öneme sahiptir. Anahtar kelimeler, ziyaretçilerin içeriğin konusunu anlamasına yardımcı olur.YouTube’da anahtar kelimelerin doğru kullanımı, platformun videonuzu tanımasını, dizine eklemesini ve kullanıcı sorgularıyla eşleştirmesini kolaylaştırır.YouTube’a video yüklerken, başlık, etiket ve açıklama gibi belirli alanlara anahtar kelimeler ekleyebilirsiniz — bunu anlamlı bir şekilde yaptığınızdan emin olun.Kanal videolarınıza hangi anahtar kelimeleri eklemeniz gerektiğini bilmek, keşfedilmenize ve daha fazla trafik çekmenize yardımcı olur.Anahtar kelime araştırmasına başlamak için YouTube’un kendisini kullanmanızı öneririz. Tıpkı Google’ın otomatik tamamlama özelliği gibi, YouTube’un arama önerileri de videolarınız için değerli anahtar kelimeler ortaya çıkarabilir.Başka bir yöntem ise aynı konuda içerik üreten rakip kanalları analiz etmektir. Kullandıkları başlıkları, etiketleri ve açıklamaları inceleyin.YouTube anahtar kelime araştırması için ücretsiz araçlar: Keywords Everywhere: YouTube ve Google’da aylık arama hacimlerini ve ilgili anahtar kelimeleri gösteren ücretsiz bir Chrome uzantısıdır. Google Trends: Anahtar kelimelerin mevsimsel trendlerini görmenizi sağlar. VidIQ: Herhangi bir YouTube videosu veya kanalı için istatistiksel bilgiler ve anahtar kelime verileri sunan ücretsiz bir Chrome uzantısıdır. Uzun kuyruklu (long-tail) anahtar kelimelere odaklanmanızı öneririz. Daha düşük arama hacmine sahip olsalar da genellikle daha yüksek erişim potansiyeli sunarlar. Çok rekabetçi anahtar kelimelerde sıralama almak zordur, ancak uzun kuyruklu terimler daha kolay sıralanabilir.Dikkat Çekici, İlgi Çekici Video Başlıkları OluşturunKullanıcıların gördüğü ilk şeylerden biri başlıklardır: ana hedef anahtar kelimelerinizi içermelidir. Video başlıkları, YouTube SEO’nun ana unsurlarından biridir ve arama sonuçlarındaki görünürlüğü etkiler.Başlıkları 45–50 karakter civarında tutun; en fazla 100 karakter kullanılabilir. Eylem kelimeleri ve merak uyandıran ifadeler ekleyin.Sıralamayı Desteklemek İçin Etiket KullanınWeb SEO’da meta etiketler artık önemli olmasa da, YouTube’da etiket kullanmak daha üst sıralara çıkmak için önemlidir. Etiketler videoları tanımlamaya ve önermeye yardımcı olur, kanal trafiği için güçlü bir kaynaktır.YouTube etiketler için 120 karaktere kadar izin verir. Hedef anahtar kelimelerinizden çeşitli kombinasyonlar ekleyin.Sıralamaya Yardımcı Açıklamalar YazınAçıklama alanı hem kullanıcılar hem de YouTube SEO için kritik öneme sahiptir. Video konusunu net şekilde açıklayın ve hedef anahtar kelimelerinizi ekleyin.5.000 karaktere kadar alanınız vardır — başlığa sığdıramadığınız anahtar kelimeleri burada kullanabilirsiniz.Açıklamaları meta açıklamalar gibi düşünün: izleyicileri izlemeye ikna ederler. CTA’lar ve varsa web sitenize bağlantılar ekleyin, ayrıca önemli bölümleri öne çıkarmak için zaman damgaları (timestamp) ekleyin. 15’e kadar hashtag ekleyebilirsiniz, ancak abartmaktan kaçının.Video Dosya Adınızı Optimize EdinYouTube SEO yalnızca platform içi optimizasyonlardan ibaret değildir. Yüklemeden önce video dosya adınızı anahtar kelimeler içerecek şekilde yeniden adlandırın — örneğin, “VID_1234.mov” yerine “youtube-seo-ipuclari.mov” kullanın. Bu, algoritmaya içeriğiniz hakkında erken bir ipucu verir.Altyazı ve Transkript KullanınAlgoritmalar videoları “izleyemez” ama metinleri okuyabilir. Transkript ve altyazı eklemek, içeriğinizin dizine eklenmesine yardımcı olur ve sıralamanızı güçlendirir.Transkriptler konuşulan içeriği metne dönüştürür; manuel olarak veya araçlarla oluşturabilirsiniz. İzleyicilerin kolay takip etmesi için zaman damgaları ekleyin.Özel Küçük Resimler OluşturunKüçük resimler (thumbnail), tıklanma oranlarını önemli ölçüde artırır. Arama sonuçlarında, küçük resim, başlık ve açıklama videonuzu izletmek için ikna edici unsurlardır.Konuğunuzu görsel olarak yansıtan resimler seçin ve üzerine metin bindirin. OCR teknolojisi sayesinde YouTube ve Google küçük resimlerinizdeki metinleri de anlayabilir.Son Ekranlar ve Kartlar Kullanınİzleyicilerin harekete geçmesini istiyorsanız, YouTube kartları ve son ekranlarını kullanın. Diğer videoları sözlü olarak önerebilirsiniz, ancak kartlar izleyicilerin kanalınızda daha uzun kalmasını sağlar.Kartlar, videonun sağ üst köşesinde görünen görsel bildirimlerdir — video başına 5 adede kadar ekleyebilirsiniz ve bunlarla diğer videolara veya bağlantılara yönlendirebilirsiniz. Son ekranlar ise videonun sonunda görünür ve abone olma, video izleme veya web sitesi ziyareti gibi eylemler için kullanılır.Profesyonel YouTube SEO İpuçlarıAlgoritmaların videolarınızı daha çok tercih etmesine yardımcı olacak ileri düzey ipuçları şunlardır: Videoları en az 2 dakika uzunluğunda tutun; en üst sıralardaki videolar ortalama 10 dakikanın üzerindedir, Odak anahtar kelimenizi her zaman başlığa ekleyin, Açıklamalarda dikkat çekici ilk satırlar yazın, Dikkat çeken küçük resimler kullanın, Videolarınızda yorumları teşvik edin, Video bağlantılarını YouTube dışı platformlarda paylaşın — bloglar, e-postalar, forumlar, web siteniz ve sosyal medya aracılığıyla daha fazla trafik çekin. YouTube Analitiğini Sürekli İzleyinYouTube analitikleri, SEO stratejinizi şekillendirmek için çok önemlidir. Nelerin işe yaradığını ve nelerin yaramadığını belirleyin.YouTube SEO için mutlaka takip edilmesi gereken metrikler: İzlenme Süresi: İzleyicilerin içeriğinizi izlemeye harcadığı toplam dakika, Gösterim Tıklanma Oranı: YouTube ana sayfası/arama sayfalarındaki gösterimlerin kaçının izlemeye dönüştüğü, Kart Tıklanma Oranı: İzleyicilerin kartlarınıza tıklama oranı, Trafik Kaynakları: İzleyicilerinizin nereden geldiğini takip eder, Benzersiz İzleyiciler: Belirli bir dönemde tahmini farklı izleyici sayısı, Abone Artışı: Abone sayınızdaki değişiklikleri izler. YouTube SEO Stratejinizi Güçlendirecek AraçlarYouTube SEO’nuzu güçlendirmek için bu araçları kullanın: Canva: Kanal logoları, kartlar ve küçük resimler tasarlayarak tıklanma oranını artırın. VidIQ: Herhangi bir kanal veya videonun etiketlerini, izlenme süresini ve stratejisini analiz eden bir Chrome uzantısı. TubeBuddy: Kanalınızı yönetmenize yardımcı olur ve etiket önerileri sunar. Ahrefs Keywords Explorer: YouTube’a özel en iyi anahtar kelime araştırma araçlarından biridir. SonuçSEO’da kullanıcıların bir sitede daha uzun süre kalması, algoritmalar açısından daha değerli kabul edilir — aynı durum YouTube için de geçerlidir.İzleyicileri kanalınızda ne kadar uzun süre tutarsanız, algoritma o kadar çok fark eder.YouTube’da sıralama elde etmek için pahalı ekipmanlara veya üst düzey prodüksiyonlara ihtiyacınız yoktur. İzleyicilere gerçekten yardımcı olan, ilgi çekici videolar üretmeye odaklanın.Bu rehberdeki YouTube SEO ipuçlarını ve önerilerini kullanarak stratejinizi güçlendirin — sonuçta Google ve YouTube gibi platformlar her zaman kullanıcı deneyimini önceliklendirir.

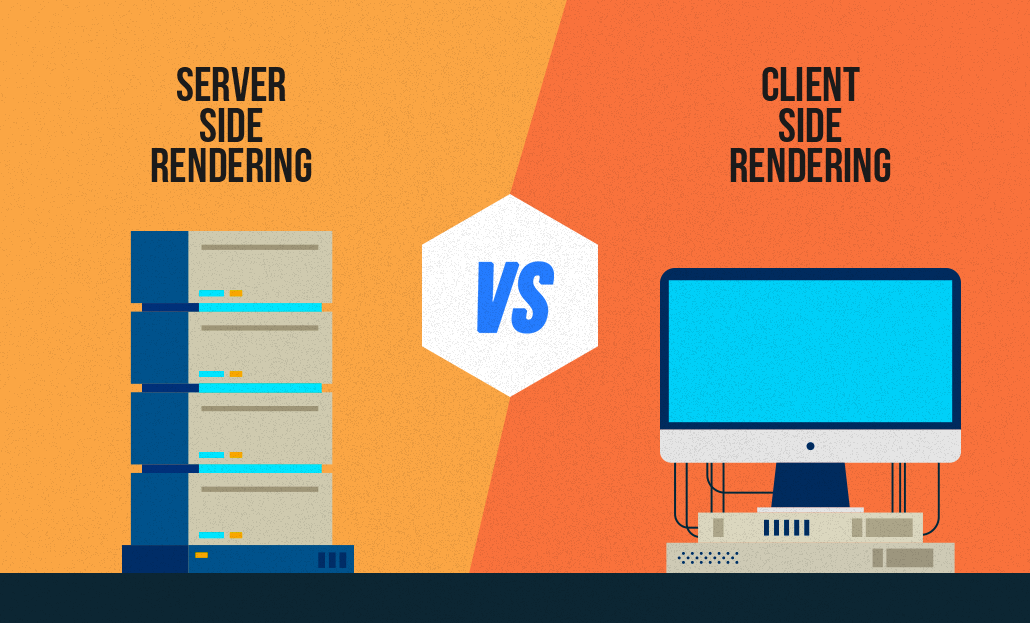

Client-Side Rendering (CSR) ve Server-Side Rendering (SSR) Nedir?

Javascript ile yazılmış siteleri arama motoru botlarının daha iyi anlaması, taraması ve dizine eklemesi için yapılan tüm çalışmalara Javascript SEO denir. Metin, görsel ve video içeriklerinin tam taranabilirliğini analiz etmek, SEO uzmanları için en önemli önceliktir. Javascript ile yazılan web sitelerinin artışıyla birlikte Javascript SEO çalışmaları da başlamıştır. Modern frontend kütüphaneleri (React JS, Vue JS, Angular JS, vb.) burada yeni bir çalışma alanının önünü açmıştır. Daha temelden bakacak olursak, bildiğimiz gibi web sayfaları 3 ana bölümden oluşur. 1. HTML – Web sitenizin iskeleti ve içerik alanı olarak düşünebiliriz. Tamamen HTML’den oluşan bir sayfa size bilgi verebilir ancak cazip bir tasarım sunmaz.2. CSS – HTML’e görsellik ve tasarım ekleyen CSS dosyalarıdır. CSS sayesinde alışık olduğumuz web sayfası tasarımına ulaşabiliriz.3. Javascript – Bir web sitesinde hareketli veya değişken alanları sağlayan programlama dilidir. Bir alanın üzerine geldiğinizde renginin değişmesi veya sayfayı aşağı kaydırdığınızda alt kısımda yeni içeriklerin yüklenmesi Javascript sayesinde gerçekleşir. Kullanıcının hareketine göre Javascript dosyaları arka planda çalıştırılır ve kullanıcıya gösterilecek son yapı hazırlanır. Yazılım tarafındaki gelişmelerle birlikte son zamanlarda web siteleri sadece JS ile kodlanmaya başladı. Kod satırları HTML içerisinde tek tek sunulmaz, doğrudan JS dosyaları üzerinden verilir. Peki, Google bu gelişmelere ne kadar uyum sağlayabildi?Google & Javascript İlişkisi Google son yıllarda Javascript sitelerini çok daha iyi anlamaya ve yorumlamaya başladı. Ancak doğrudan JS ile yazılmış siteleri taramak Google için çok maliyetlidir. Normal bir siteye kıyasla daha fazla zaman harcar ve sunucularını yorar. Peki Google bu maliyeti optimize etmek için ne yapıyor? Google, Javascript ile yazılmış sayfaları taramak için 2 aşamalı tarama yöntemini kullanır. İlk aşamada Googlebot sitenize girer, HTML ve CSS’i tarar ve dizine ekler. Burada Javascript dosyalarını da görür ancak bunları taramayı ve anlamayı 2. aşamaya bırakır. Bu arada, ilk aşamada kullanıcıya görünen kadarıyla sonuçları göstermeye başlar. Sitenizi kendi içinde 2. dalga tarama için sıraya alır. Bu işlem saatler veya günler sürebilir. Google, sitenizi değerine ve otoritesine göre önceliklendirerek sıraya koyar. 2. dalga geldiğinde ise Javascript dosyalarını da tarar ve dizine ekler. Böylece aslında sizin planladığınız son hali kullanıcıya göstermeye başlar. Javascript Google İçin Diğer Dillerden Nasıl Farklıdır? Kullandığımız tarayıcılar HTML, CSS ve JS’i render motorları aracılığıyla işler. Bu nedenle önce render edilmesi gerekir. PHP ve Python gibi diller, sunucu tarafında render edilen diller olarak öne çıkar. JS ile kodlanan Angular ve React gibi alternatifler ise hem Sunucu Tarafı Rendering (SSR) hem de İstemci Tarafı Rendering (CSR) yöntemleriyle render edilebilir. GoogleBot Javascript Siteleri Nasıl Taramaktadır? Javascript ile yazılmış sitelerin arama motoru botları tarafından doğru şekilde taranması ve dizine eklenmesi için 2 farklı yöntem vardır. İstemci Tarafı Rendering (CSR) (Dinamik Rendering dahil) Sunucu Tarafı Rendering (SSR) İstemci Tarafı Rendering (CSR) Kullanıcı veya arama motoru tarayıcısı sitenize istek gönderir. Sunucu isteği kabul eder ve yanıt döner. Tarayıcı, içerik ve beraberindeki JS dosyalarını indirir. Tarayıcı içeriği görüntülemek için JS dosyalarını çalıştırır. İçerik kullanıcılar ve botlar tarafından etkileşime açık hale gelir. CSR’ın Artıları ve Eksileri (+) İlk sayfa yüklemesinden sonra daha hızlı işlem (+) Sunucuya daha az yük bindirir (+) Zengin site etkileşimi sağlar (+) Hızlı site içi gezinme sağlar (her sayfa yüklemesinde yeniden indirilmeye gerek kalmadığı için daha az HTTP isteği) (-) İlk sayfanın daha yavaş yüklenmesi (birden fazla sayfa için gerekli varlıkların yüklenmesinden dolayı) (-) Düşük işlemcili cihazlarda geç yüklenme (-) İnternet bağlantısı zayıf olduğunda geç yüklenme (-) Doğru uygulanmazsa SEO’yu olumsuz etkiler. (Sayfa açılışında Javascript kodları çalışana kadar boş görünebilir) (-) Çok sık harici kütüphanelere ihtiyaç duyar CSR SEO Riskleri En modern teknolojilerle hazırladığınız sayfa Google için boş bir sayfa gibi görünebilir. Modern Javascript kütüphaneleriyle yazılmış bir siteniz varsa, Google’ın sitenizi nasıl gördüğünü Google Search Console’daki URL Denetleme aracındaki "Taranan Sayfayı Göster" butonuyla sık sık kontrol edin. Sayfanız hâlâ Google dizininde değilse, canlı URL üzerinden de test edebilirsiniz. Dinamik Rendering Dinamik Rendering, CSR ile oluşturulmuş sitelerin SEO uyumlu olması için kullanılan bir yöntemdir. Temel fark, GoogleBot’a ve kullanıcılara farklı render formatları sunmasında yatar. Sunucuya istek geldiğinde, bu isteğin GoogleBot tarafından mı yoksa kullanıcı tarafından mı yapıldığı anlaşılır. Eğer GoogleBot tarafından yapıldıysa, sunucu tarafında render edilen bir HTML yanıtı döner. Kullanıcılar ise sitenizi CSR olarak görmeye devam eder. Sunucu Tarafı Rendering (SSR) Kullanıcı veya arama motoru tarayıcısı sitenize istek gönderir. Sunucu isteği kabul eder, tüm HTML’i render eder ve yanıt döner. Tarayıcı oluşturulan HTML ve JS dosyalarını indirir. İçerik kullanıcılar ve botlar tarafından etkileşime açık hale gelir. SSR’ın Artıları ve Eksileri (+) Sayfaların daha hızlı yüklenmesini sağlayarak kullanıcı deneyimini iyileştirir. (+) SEO açısından avantajlıdır. (+) Statik içerik sunan siteler için çok daha ideal bir yapıdır. (+) Daha az JS bağımlılığı vardır. (+) Kullanıcının internet bağlantısı yavaş olduğunda da idealdir. (-) Sunucunun çok sayıda ziyaretçisi olduğunda veya site büyük olduğunda sayfa render süresinde ciddi yavaşlamalara yol açabilir. (TTFB zamanı etkilenebilir) (-) Her gezinmede tüm sayfanın yeniden yüklenmesi gerekir. (-) Daha yüksek performans için sunucu maliyetleri artacaktır.