Analytica House

Eyl 4, 2022SEO Performansı Açısından Log Dosyası Analizi

SEO performansı açısından, log dosyası analizi—özellikle sunucunun erişim loglarını incelemek—arama motoru botlarının sitemizi taradıktan sonra nasıl davrandığını bize tam olarak gösterir.

Bu makalede, “SEO için detaylı log dosyası analizi nasıl yapılır?” ve “Log analizi yapmanın faydaları nelerdir?” sorularını çeşitli senaryo tabanlı örneklerle cevaplayacağız.

Log Dosyası Nedir?

Log dosyaları, sitenize kimin, ne zaman, hangi IP’den ve hangi URL’leri talep ederek eriştiğini kaydeder.

“Ziyaretçiler” sadece insan kullanıcıları değil, Googlebot ve diğer arama motoru tarayıcılarını da içerir.

Web sunucunuz bu logları sürekli yazar ve belirli bir süre sonra döndürür veya üzerine yazar.

Log Dosyası Hangi Verileri İçerir?

Tipik bir erişim log girişi şöyle görünür:

27.300.14.1 – – [14/Sep/2017:17:10:07 -0400] “GET https://allthedogs.com/dog1/ HTTP/1.1” 200 “https://allthedogs.com” “Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)”

Sunucu yapılandırmanıza bağlı olarak, yanıt boyutunu veya istek gecikmesini de loglayabilirsiniz. Ana alanların açıklaması:

- IP adresi isteği yapanın

- Zaman damgası isteğin zamanı

- Metod (GET veya POST)

- Talep edilen URL

- HTTP durum kodu (bkz. HTTP durum kodları)

- User-Agent stringi, istemci veya bot türünü gösterir

Googlebot IP Adres Listesi

Kasım 2021’de Google, web sitelerini taramak için kullandığı tüm IP aralıklarının listesini yayınladı. JSON dosyasına buradan ulaşabilirsiniz:

https://developers.google.com/search/apis/ipranges/googlebot.json

Log Dosyalarınızı Nerede Bulabilirsiniz?

Loglar web sunucunuzda veya bazı durumlarda CDN’nizde bulunur. Onlara nasıl erişeceğiniz, sunucu altyapınıza (nginx, Apache, IIS) ve kontrol panelinize bağlıdır. Örneğin:

cPanel: /usr/local/apache/logs/ veya “Raw Access Logs” özelliği üzerinden

Plesk: /var/www/vhosts/system/your-domain.com/logs/

Log Analizi SEO İçin Neden Önemlidir?

Logları analiz etmek, botların hangi URL’leri gerçekten talep ettiğini ve hata ile karşılaşıp karşılaşmadığını tam olarak gösterir.

Screaming Frog veya DeepCrawl gibi araçların aksine, botlar sadece linkleri takip etmez; daha önce gördükleri URL’leri tekrar ziyaret eder. Eğer bir sayfa iki gün önce mevcutken şimdi 404 veriyorsa, sadece loglar bu uyumsuzluğu ortaya çıkarır.

Log analizi size şunları gösterebilir:

- Botların en çok hangi sayfaları taradığı (ve hangilerini görmezden geldiği)

- Botların 4xx veya 5xx hatalarıyla karşılaşıp karşılaşmadığı

- Hala taranan bağlantısız (orphan) sayfalar

Log Dosyası Analizi İçin Araçlar

Popüler log analizi araçları şunlardır:

- Splunk

- Logz.io

- Screaming Frog Log File Analyser (1.000 satıra kadar ücretsiz)

- Semrush Log File Analyzer

GSC Crawl Stats ve Loglar

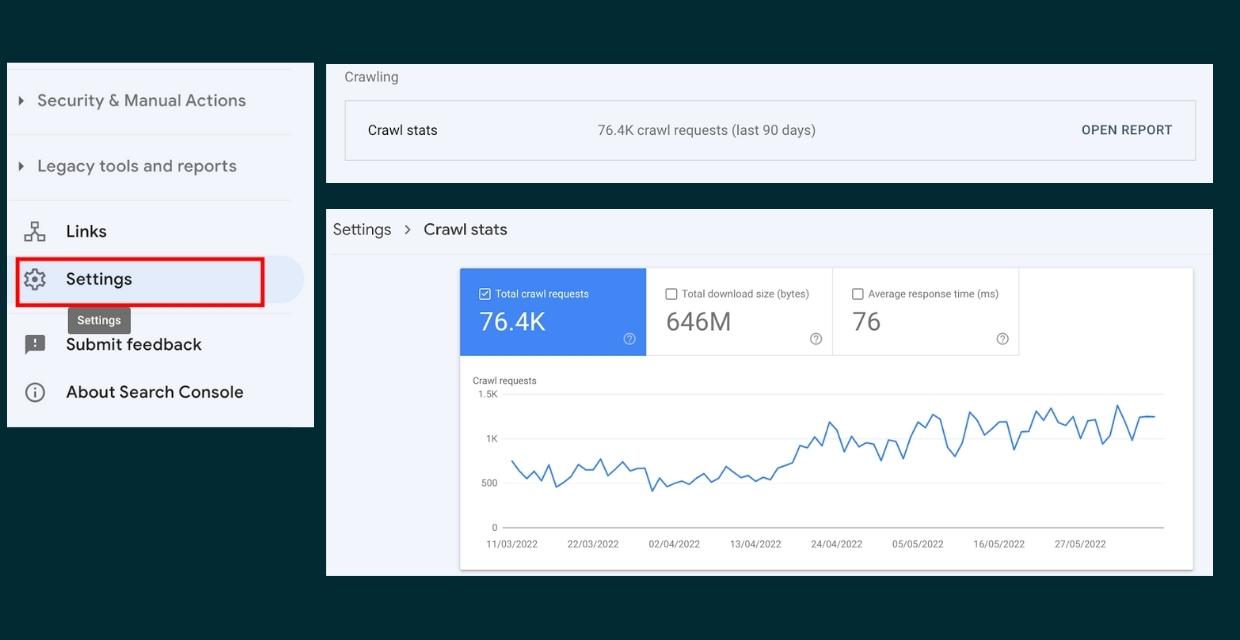

Google Search Console’un Crawl Stats raporu bazı üst düzey tarama verilerini gösterir, ancak ham loglar kadar detaylı değildir.

Raporu açmak için: Settings > Crawling > Open report.

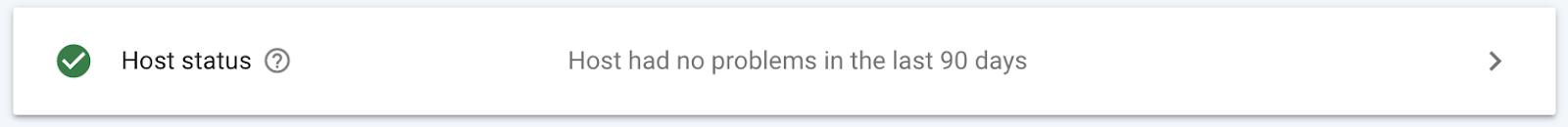

Tarama İstatistiklerini Yorumlama

- Hepsi iyi: Son 90 gün içinde tarama hatası yok

- Uyarı: Hata 7 günden daha önce meydana gelmiş

- Kritik: Son 7 gün içinde hata tespit edildi

Rapor ayrıca durum kodu, dosya türü ve bot türüne (masaüstü, akıllı telefon, AdsBot, ImageBot vb.) göre ayrım yapar.

Log Analizinizi Nasıl Yorumlarsınız?

Loglarla şunları cevaplayabilirsiniz:

- Botlar sitemin yüzde kaçını gerçekten tarıyor?

- Hangi bölümler hiç taranmıyor?

- Botlar site içinde ne kadar derine gidiyor?

- Güncellenmiş sayfaları ne sıklıkla tekrar ziyaret ediyorlar?

- Yeni sayfalar ne kadar hızlı keşfediliyor?

- Site yapısı değişikliği tarama düzenini etkiledi mi?

- Kaynaklar (CSS, JS) hızlı bir şekilde sunuluyor mu?

7 Örnek Senaryo

İşte log analizi ile SEO stratejinizi bilgilendirebileceğiniz yedi pratik yol:

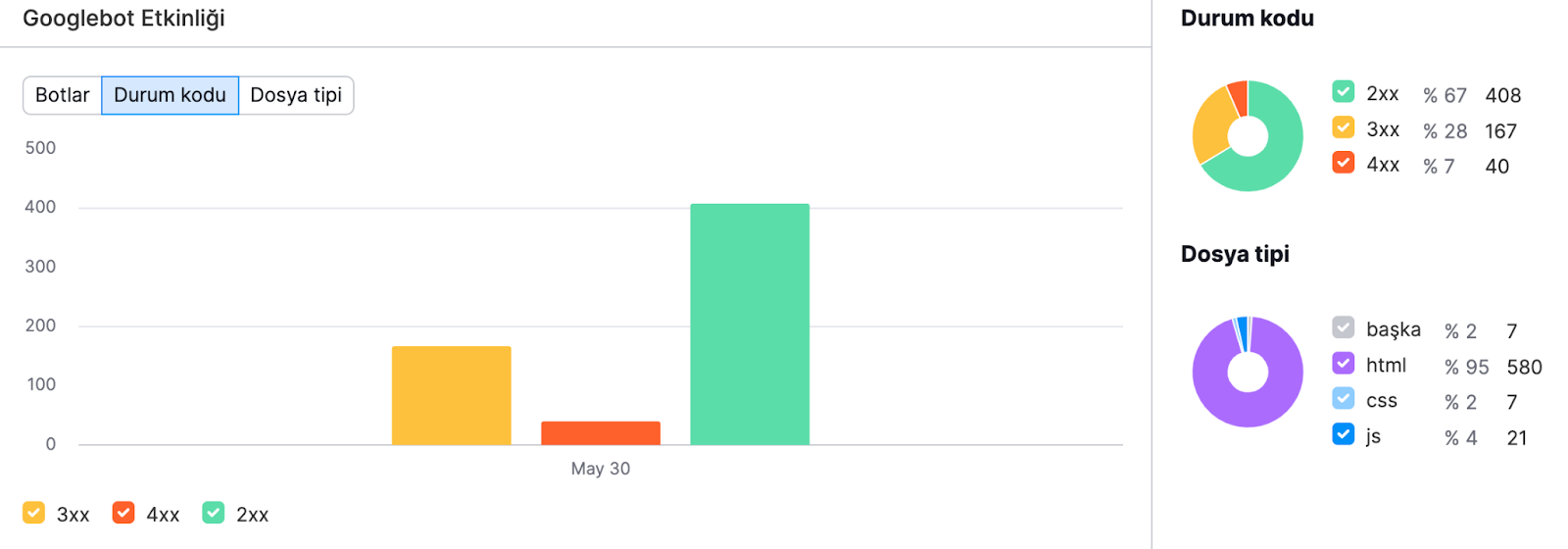

1. Tarama Davranışını Anlayın

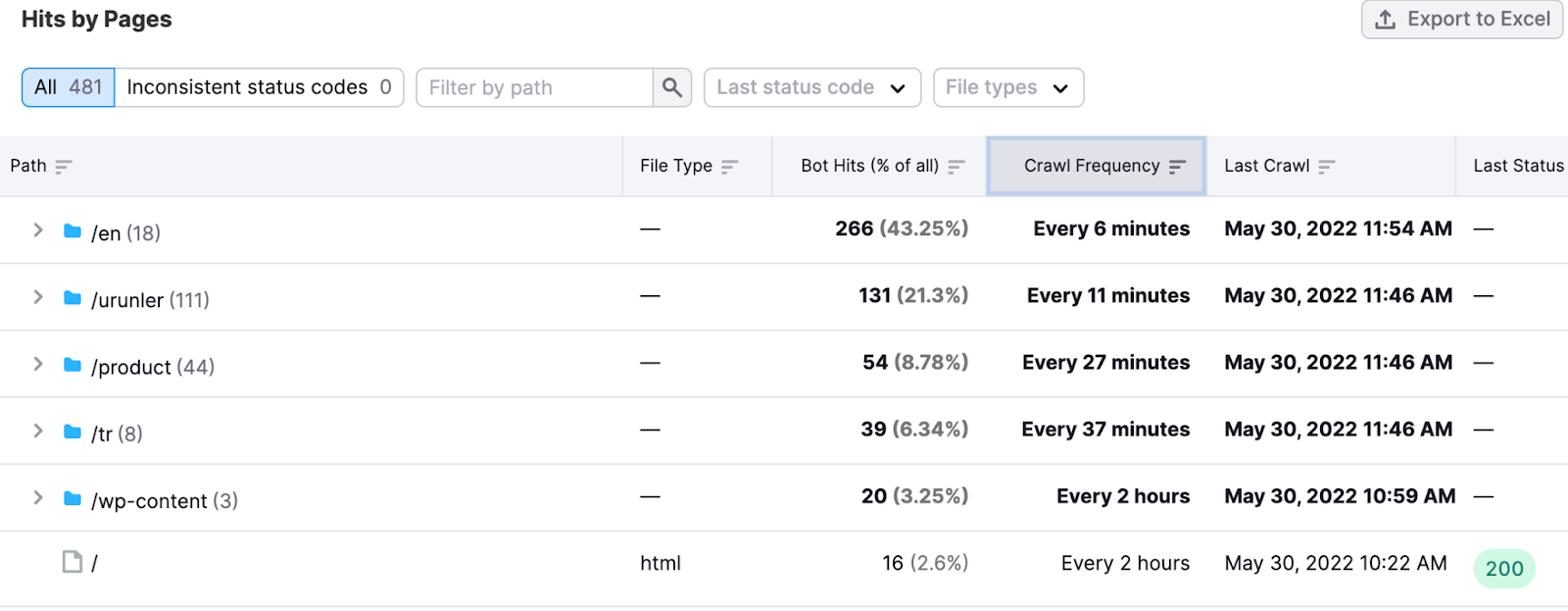

Botların en sık hangi durum kodlarını gördüğünü ve hangi dosya türlerini talep ettiğini kontrol edin. Örneğin, Screaming Frog log raporunda:

- HTML/CSS/JS üzerindeki 2xx kodları idealdir—sayfalar başarıyla yüklenir.

- 4xx kodları, kırık linkler veya kaldırılmış sayfaları gösterir—bu, tarama bütçesini boşa harcayabilir.

- 3xx kodları yönlendirmeleri gösterir—yalnızca gerekli yönlendirmelerin kaldığından emin olun.

2. En Önemli Sayfalarınızı Belirleyin

Botlar, daha fazla iç veya dış linke sahip sayfalara daha fazla tarama bütçesi ayırır. Örneğin, bir İngilizce alt dizinde aşırı tarama görüyorsanız, navigasyon veya iç linklemeyi ayarlayabilirsiniz.

3. Tarama Bütçesini Optimize Edin

Daha küçük siteler bile israfı ortadan kaldırmaktan fayda sağlar. Logları kullanarak gereksiz parametreli URL taramalarını, sık 301 yönlendirmelerini veya robots.txt hatalarını tespit edin.

- Sitemap ve iç linklerden parametreli URL’leri kaldırın.

- Statik varlıklar için uzun Cache-Control başlıkları belirleyin.

- Çoklu yönlendirmeleri tek zincirde birleştirin.

- Robots.txt yazım hatalarını düzeltin, böylece botlar tarama kurallarınıza uyar.

4. Tarama Hatalarını Tespit Edin

Yüksek miktarda 4xx/5xx yanıtı, botların taramayı yavaşlatmasına veya durdurmasına neden olabilir. 2xx ve hata oranlarını karşılaştırın ve kırık sayfaları hızlıca düzeltin.

5. Tarama Yapılabilir Ama İndekslenmemiş Sayfaları Bulun

İndekslemeye uygun ancak nadiren taranan sayfaları, düşük tarama sıklığı filtreleyerek bulabilirsiniz—ör. “XX hafta önce.”

Bu sayfaları sitemap’e ekleyin, iç link verin ve içeriklerini güncelleyin.

6. Orphan Sayfaları Keşfedin

Bağlantısız (orphan) sayfalar hala loglarda görünebilir. Sıfır iç referansı olan 200-OK HTML URL’leri için logları filtreleyin. Ardından iç link ekleyin veya gerekli değilse kaldırın.

7. Site Taşımalarına Yardım Edin

Taşıma sırasında, en çok taranan URL’ler loglarda gösterilir; böylece yönlendirme yollarını korumaya öncelik verebilirsiniz. Taşımadan sonra loglar, botların artık bulamadığı URL’leri ortaya çıkarır.

Log Analizini SEO Düzeltmeleri İçin Kullanın

Loglardan elde edilen bilgilerle şunları yapabilirsiniz:

- Sitemap’ten 200 olmayan URL’leri kaldırın

- Düşük değerli sayfaları noindex veya disallow yapın

- Canonical etiketlerin önemli sayfaları vurguladığından emin olun

- Stratejik sayfalara iç link ekleyerek tarama sıklığını artırın

- Tüm iç linklerin indekslenebilir URL’lere işaret ettiğinden emin olun

- Yeni ve güncellenmiş içerikler için tarama bütçesini serbest bırakın

- Kategori sayfalarının düzenli tarandığını doğrulayın

Sonuç

Log dosyası analizi, gizli SEO sorunlarını keşfetmek ve tarama stratejinizi iyileştirmek için güçlü bir yoldur. Bu rehberi faydalı bulduysanız, başkalarının da faydalanabilmesi için sosyal medyada paylaşın!

More resources

Nöropazarlama ile Dijital Reklamları Yeniden Düşünmek

Nöropazarlama, dijital reklamcılığın geleceğini yeniden şekillendiriyor; tüketici beyninin nasıl kar...

Bir Analytics Ajansı ROI’yi Nasıl Etkiler?

Dijital pazarlama dünyasında başarı yalnızca reklam bütçesine veya kampanya çeşitliliğine bağlı deği...

2026 SEO Beklentileri ve Trendleri: Yapay Zeka, GEO ve E-Ticaret Stratejileri

2025 yılını geride bırakırken, dijital pazarlama dünyası daha önce hiç olmadığı kadar büyük bir kaym...