Burcu Aydoğdu

Haz 12, 2025Proaktif SEO: Screaming Frog Scheduling ile Raporlama ve Analiz

Manuel olarak yapılan teknik SEO denetimleri, özellikle büyük web siteleri için saatler, hatta günler sürebilen, tekrar eden ve zaman maliyeti yüksek süreçler oluyor. Bu değerli zamanı analiz ve strateji geliştirmek yerine teknik veri toplamakla harcamak, verimliliği düşürüyor. Otomasyon ise bu noktada modern SEO'nun en büyük yardımcılarından biridir ve proaktif site sağlığı yönetimine geçişi sağlıyor. Önceliklendireceğiniz sayfaları keşfetmenize yardımcı oluyor

İşte tam bu noktada Screaming Frog'un "scheduling" (zamanlama) özelliği, yorucu manuel denetimleri bir kenara bırakıp, sitenizin teknik nabzını 7/24 tutan otomatik bir sistem kurmanızı sağlayarak gerçek bir kurtarıcı rol üstleniyor.

Screaming Frog Scheduling Nedir ve Neden Hayat Kurtarır?

Screaming Frog Scheduling, SEO Spider yazılımının ücretli versiyonunda bulunan ve önceden yapılandırdığınız tarama ayarlarını, belirlediğiniz zaman ve sıklıkta otomatik olarak çalıştırmanıza imkan tanıyan bir fonksiyondur. Kısacası, siz bilgisayar başında olmasanız bile Screaming Frog'un sizin yerinize web sitenizi taramasını sağlar.

Bu özelliğin temel amacı, tekrar eden denetim görevlerini otomatize ederek insan hatasını ortadan kaldırmak, süreçleri standartlaştırmak ve en değerli kaynağınız olan zamanı size geri kazandırmaktır.

1. İlk olarak, manuel taramalara ayırdığınız haftalık saatleri ortadan kaldırarak size strateji geliştirme ve analiz için ek zaman yaratıyor.

2. İkinci olarak, her tarama önceden kaydettiğiniz aynı konfigürasyon dosyası ile çalıştığı için elde edilen veriler %100 tutarlı oluyor. Bu sayede, hafta hafta veya ay ay arasındaki değişimleri (örneğin artan 404 hataları veya bozulan yönlendirme zincirleri) net bir şekilde görebiliyorsunuz.

3. Son ve en kritik avantajı ise anlık tespit oluyor. İşte bu, potansiyel bir organik trafik felaketini daha başlamadan önlemektir.

Adım Adım Zamanlanmış Tarama (Scheduling) Kurulumu

İlk ve en önemli adım, otomatize etmek istediğiniz taramanın ayarlarını bir şablon olarak kaydetmektir.

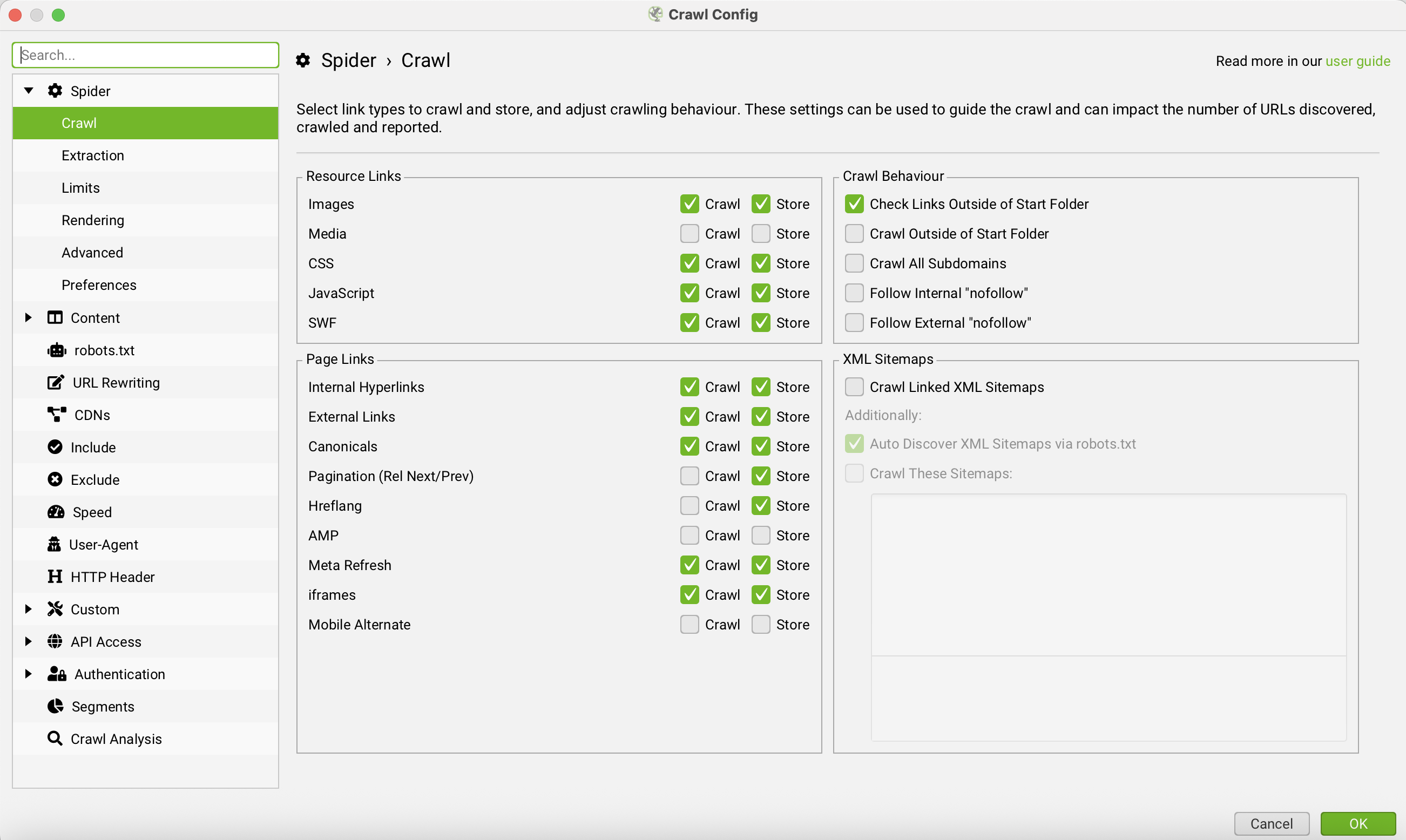

1. adım standart crawl configuration ayarlamaları yapılmalıdır. Örneğin; tarama gerçekleştirmek istediğiniz modu, taramak istediğiniz etiketleri & linkleri, tarama derinliğini ve hariç tutacaklarınızı işaretleyebilirsiniz.

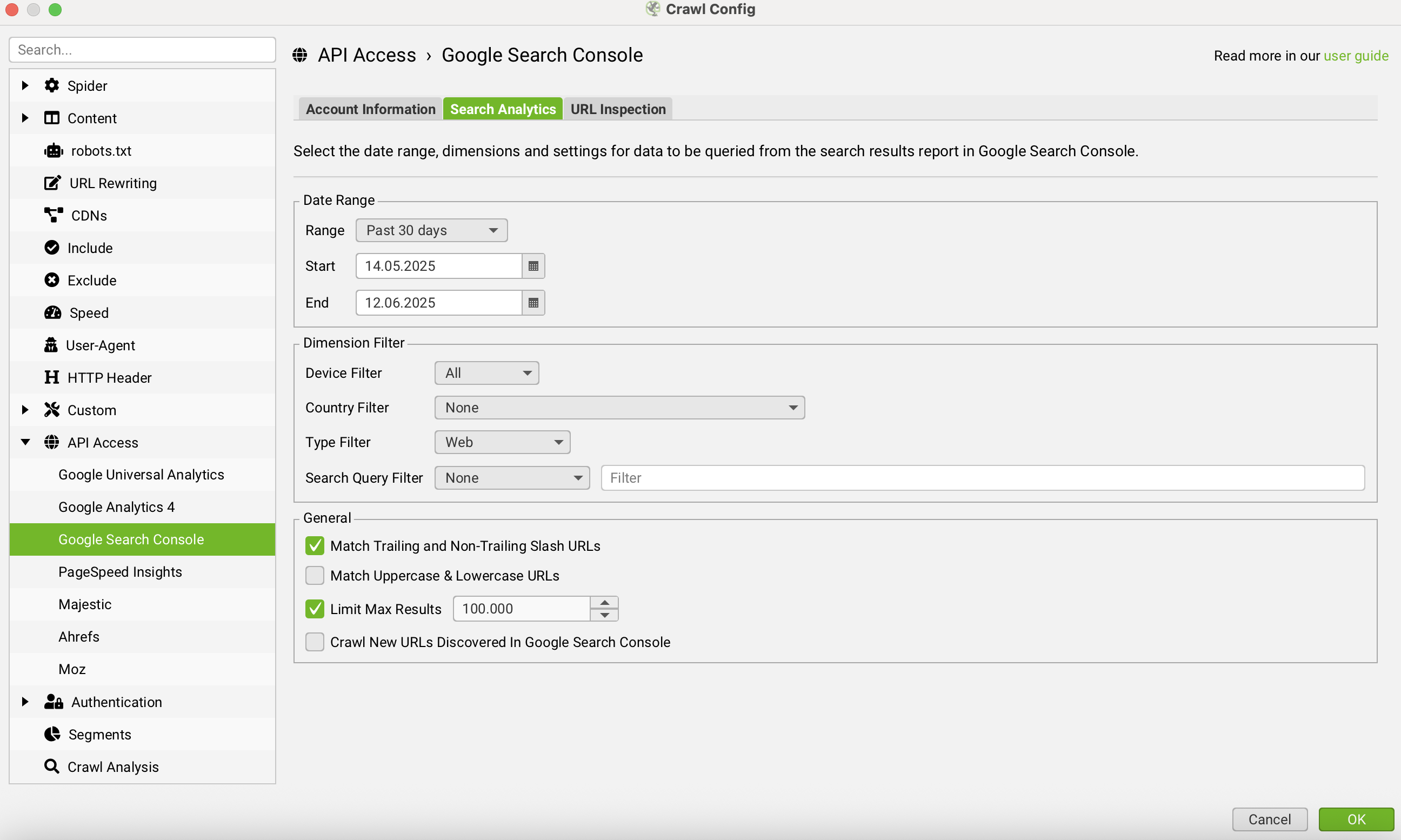

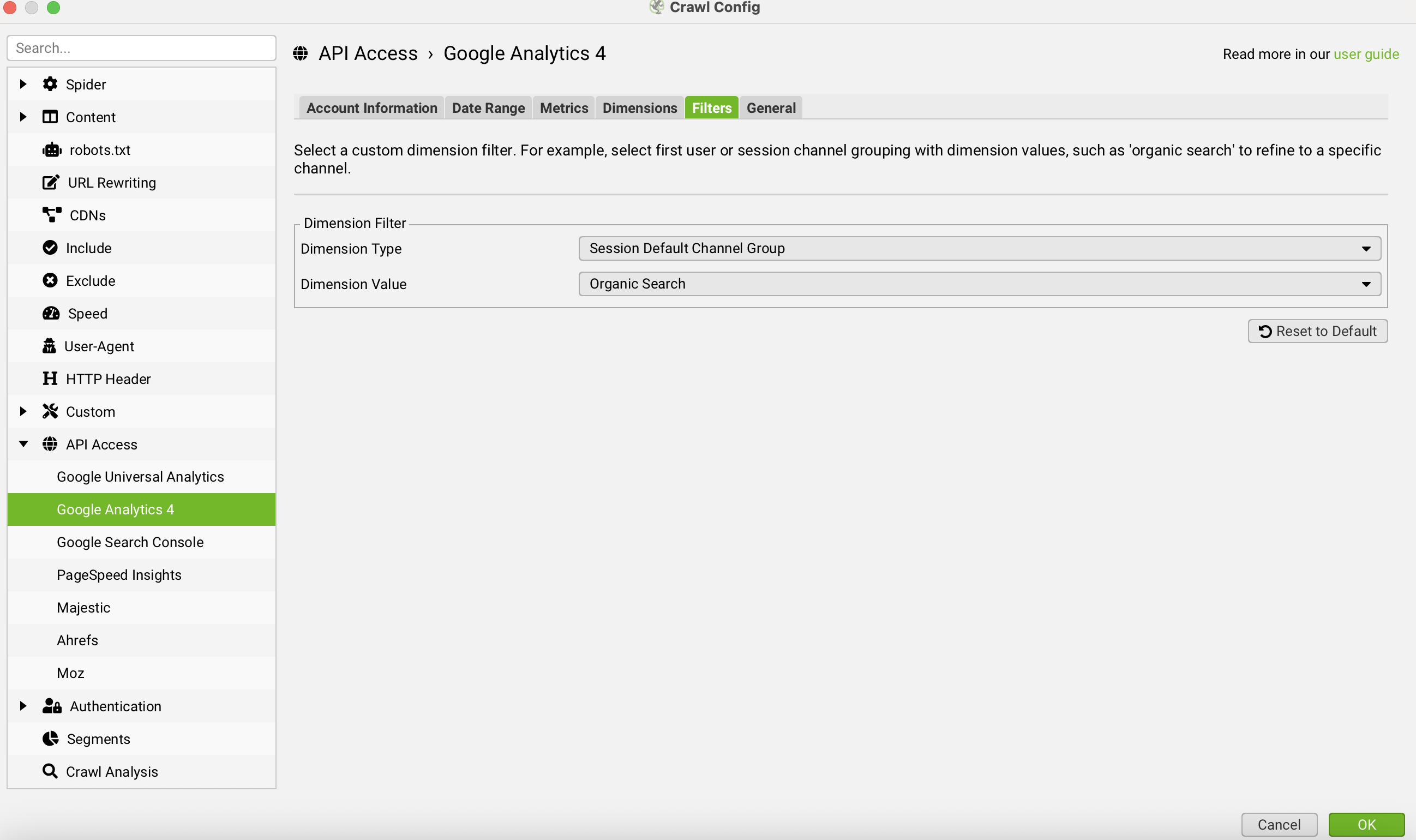

2. adım olarak Configuration > API Access alanından Google Analytics4 ve Google Search Console API entegrasyonu ile taranacak URL’lere ait gerçek zamanlı Google verilerini taramanıza entegre edebilirsiniz.

Bu işlem bittiğinde, bu ayar bütününü File > Configuration > Save As yolunu izleyerek bilgisayarınıza .seospiderconfig uzantılı bir dosya olarak kaydedebilirsiniz. Bu dosya, gelecekteki tüm otomatik taramalarınızın beyni ve planı olacaktır.

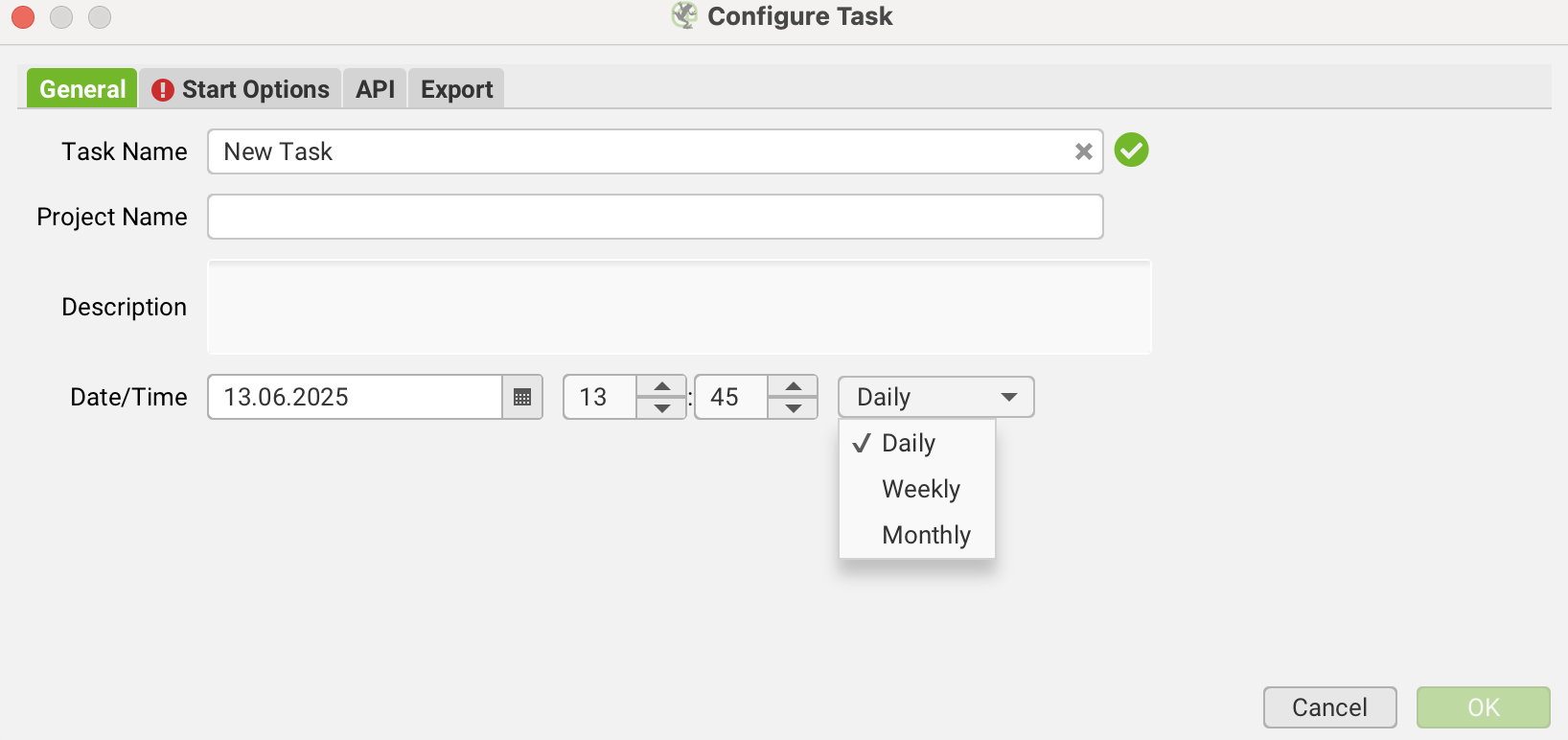

3. adım olarak zamanlama görevini oluşturabilirsiniz. File > Scheduling menüsünde yeni bir görev oluşturmak için Add (Ekle) butonuna basılır. Bu kısımdan Date/Time alanına gelerek bu görevin ne sıklıkla çalışacağını ayarlayabilirsiniz. Daily, Weekly ve Monthly ayarlamaları mevcuttur.

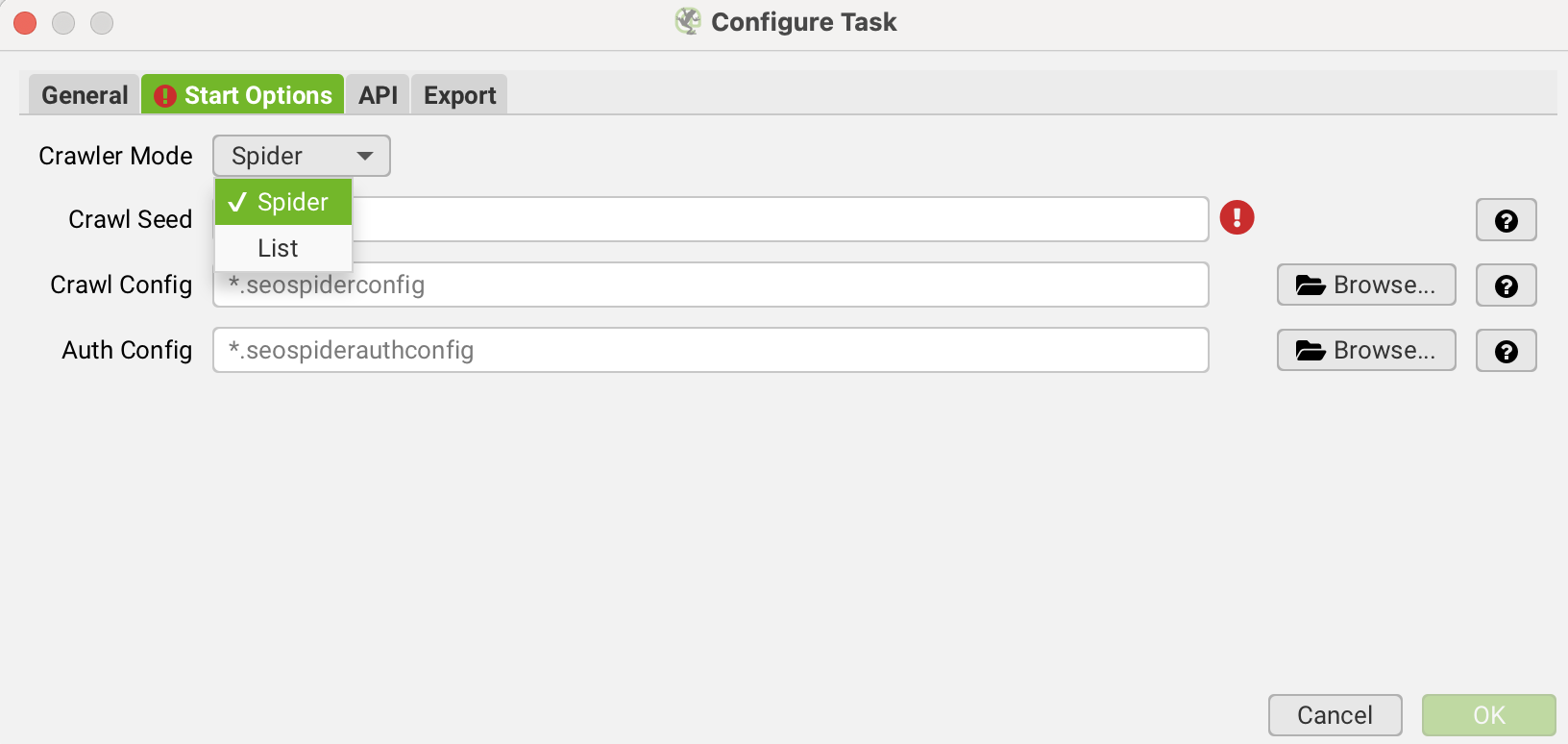

4. adım olarak crawl modu tercih edilir, burada dilerseniz list modunda da URL’leri tarayabilirsiniz. List modu için Local kaynakta bulunan bir .xlsx dosyasını da taratabilirsiniz.

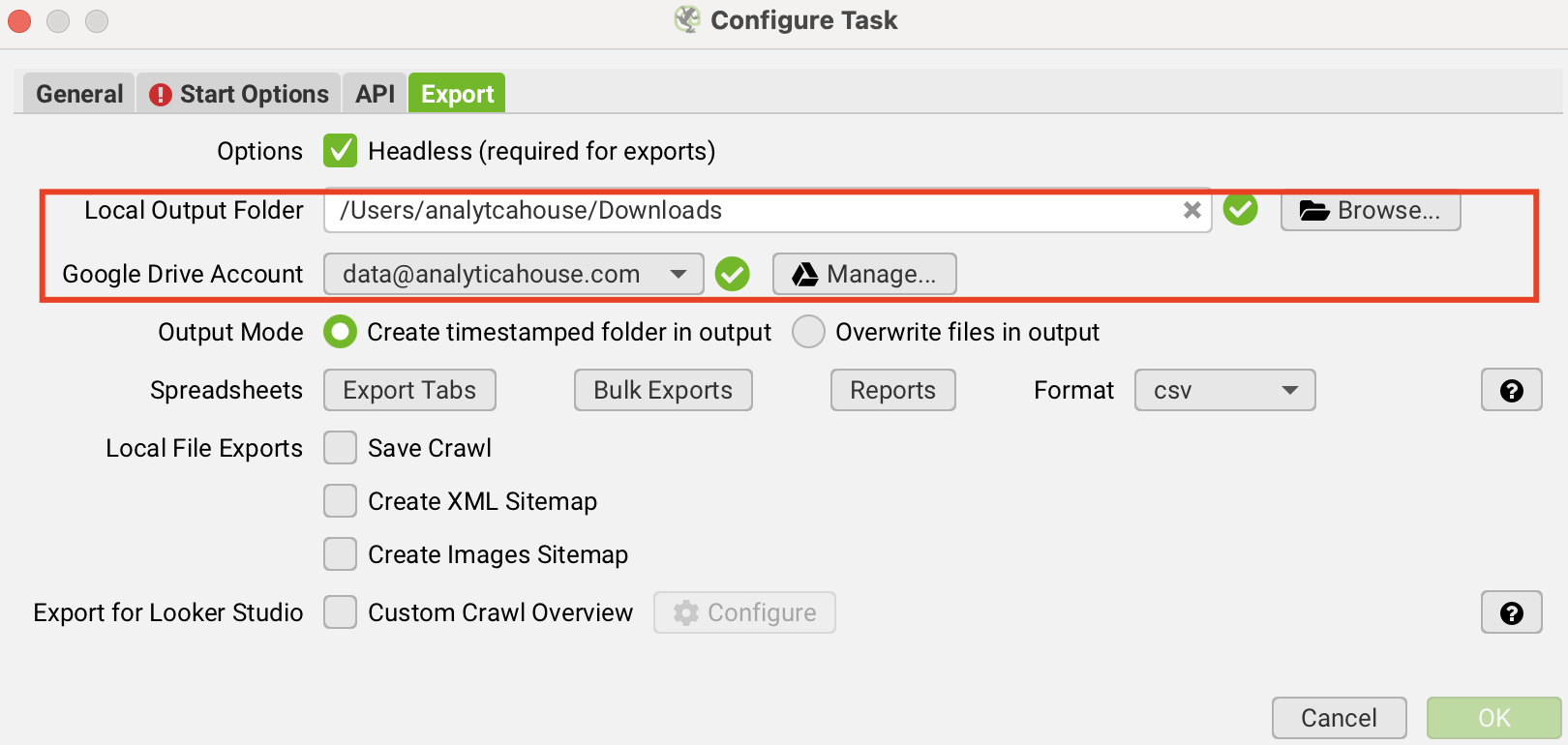

5. adım olarak çıktının hangi alana kaydedileceğini seçebilirsiniz. Örneğin, Google Drive hesabı ya Local kaynağa çıktının kaydedilmesi sağlanabilir.

Düzenli çıktıyı Google Drive klasörlerinize veya Google Sheets dosyalarınıza aktarabilirsiniz. Bu özelliği kullanmak için Google Drive Account menüsünden hesabı bağlamak yeterlidir.

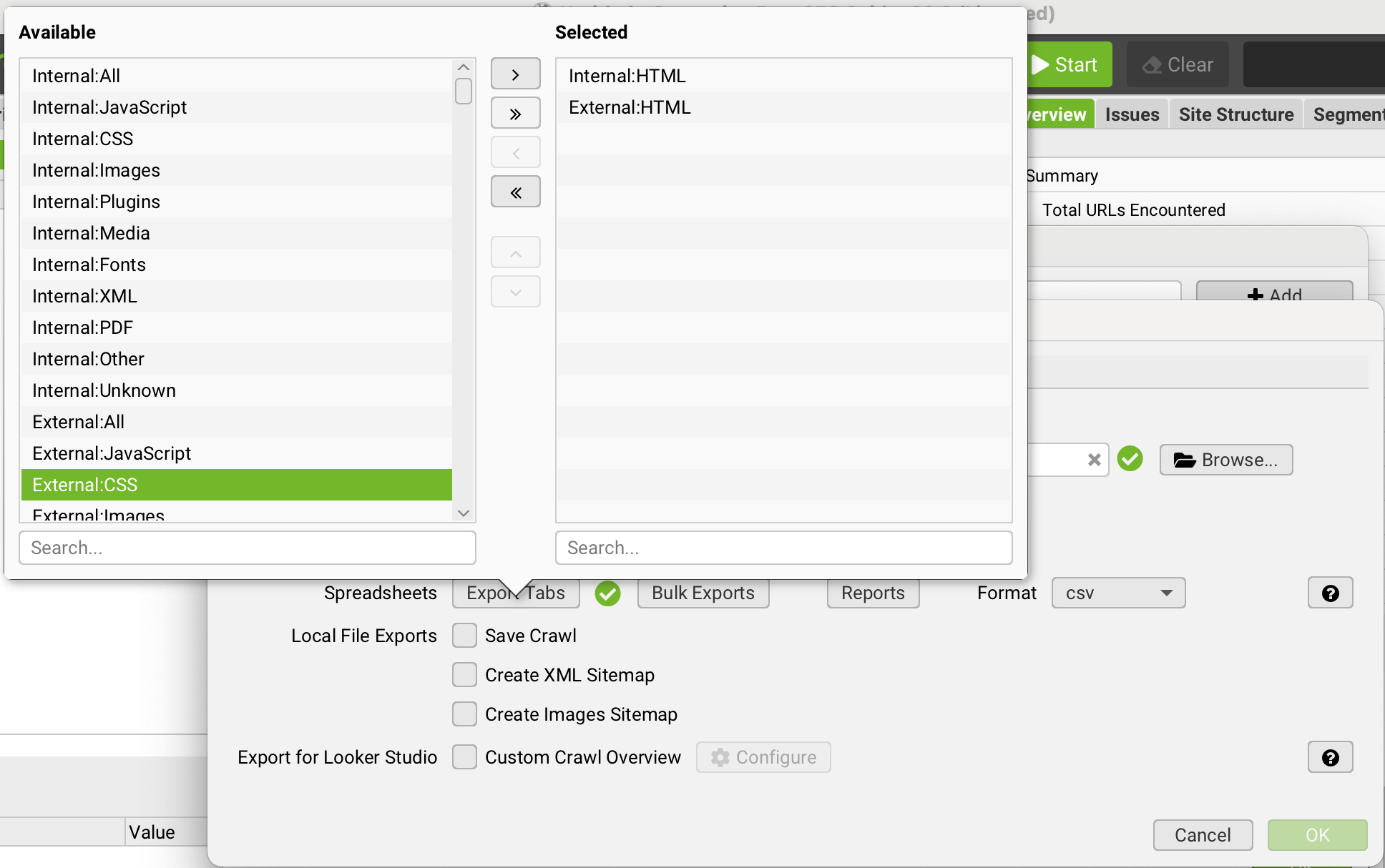

6. adım olarak Reports ve Exports sekmelerinde, tarama bittiğinde hangi hazır raporların (örneğin Yönlendirmeler, Başlık Hataları vb.) otomatik olarak oluşturulup kaydedileceğini seçebilirsiniz.

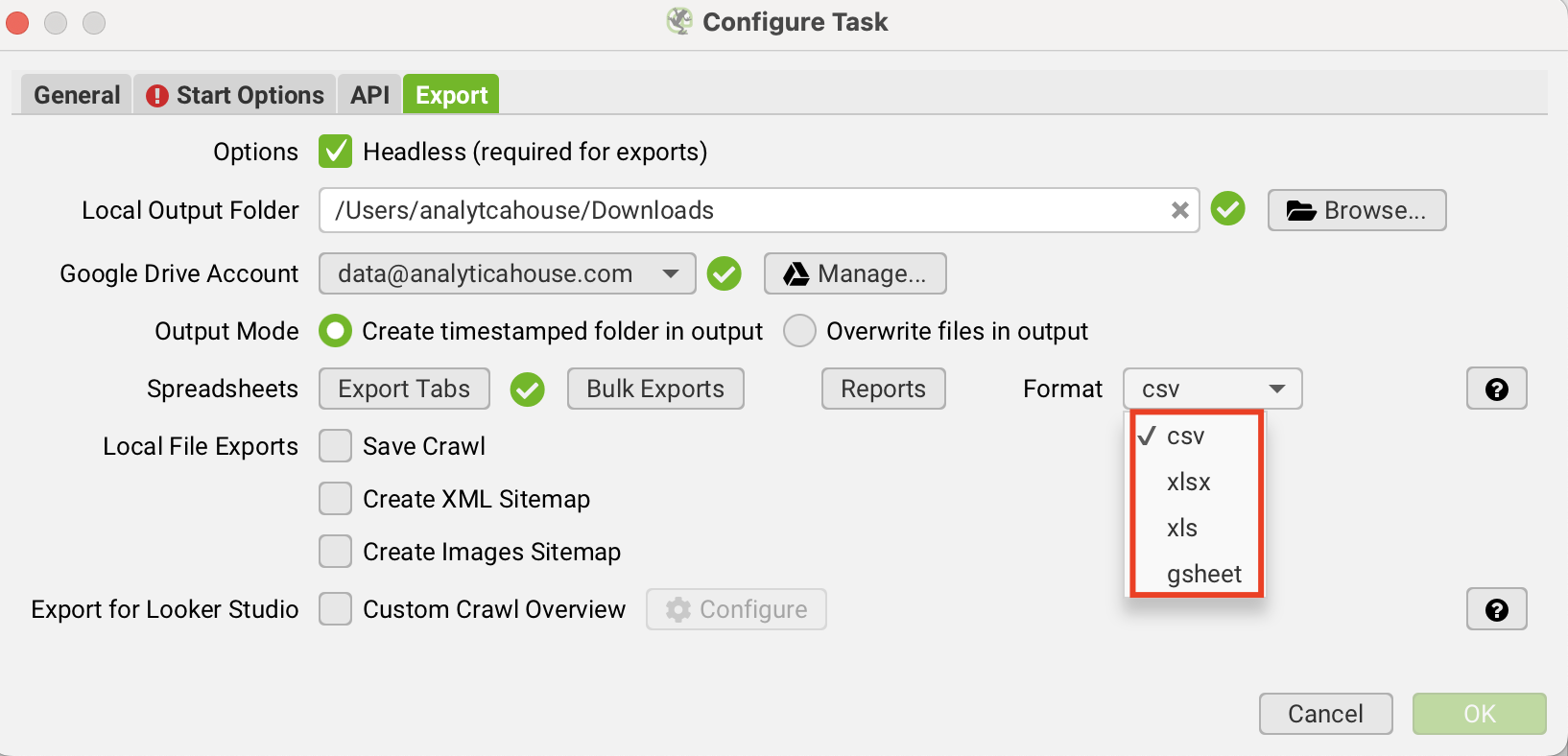

7. adım olarak da çıktının kaydedileceği formatı belirleyebilirsiniz.

Dilerseniz çıktı ile Looker Studio entegrasyonunu da sağlayabilir, veriyi taşıyabilirsiniz.

Veriyi Zenginleştirme: Google Search Console (GSC) ve GA4 API Entegrasyonu

Screaming Frog'un tek başına sunduğu teknik veriler (URL yapısı, HTTP durum kodları, meta etiketler vb.) oldukça değerlidir, ancak bu veriler bir web sitesinin hikayesinin sadece bir yarısını anlatır. Hikayenin diğer yarısı ise kullanıcıların bu sayfalarla nasıl etkileşime girdiği ve Google'ın bu sayfaları arama sonuçlarında nasıl değerlendirdiğidir.

İşte bu noktada Google Search Console (GSC) ve Google Analytics 4 (GA4) API entegrasyonu devreye girer. Bu entegrasyonun temel amacı, teknik verileri performans ve davranış verileriyle birleştirmektir. Bu sayede,

"hangi sayfaların başlığı 60 karakterden uzun?" gibi basit bir sorudan, "en çok gösterim alan ancak tıklama oranı düşük olan ve aynı zamanda LCP (Largest Contentful Paint) değeri 'zayıf' olan sayfalarım hangileri?"

gibi eyleme geçirilebilir, stratejik bir soruya geçiş yapılabilir.

Bu ayarı Screaming Frog üzerinden sağlamak için API yetkilendirmeleri tamamlanmalıdır. Hangi kaynaktaki veri ile API entegrasyonu kurmak istiyorsanız yetkilendirme işlemini sağlayabilirsiniz.

Bu bağlantıyı kurduktan ve taramanız için gerekli diğer tüm ayarları yaptıktan sonra, bu yapılandırmayı daha önce bahsettiğimiz gibi bir .seospiderconfig dosyası olarak kaydedebilir ya da Drive hesabınıza kayıt alabilirsiniz.

Zamanlanmış görevinizi oluştururken bu konfigürasyon dosyasını seçtiğinizde, Screaming Frog her otomatik tarama yaptığında GSC ve GA4'ten en güncel verileri (tıklamalar, gösterimler, TO, pozisyon, kullanıcı sayısı, oturum, dönüşümler vb.) çekecektir. Böylece, önceliklendirmeniz gereken teknik SEO görevlerini, doğrudan iş sonuçlarına etkilerine göre belirleyebilirsiniz.

Otomatik Raporlama: Gelişmiş Export Ayarları

Screaming Frog Scheduling özelliği, raporlama sürecini tamamen otomatize etmenize olanak tanır. Tam bir tarama sonrası onlarca farklı export dosyasıyla uğraşmak yerine, zamanlanmış görevinizin ayarlarından sadece ihtiyacınız olan spesifik raporları otomatik olarak oluşturmasını isteyebilirsiniz.

Örneğin, haftalık bir "Health Crawling Check" görevi için sadece "4xx", "Redirect Chains", "Canonical Issues" ve "Non-indexable Pages" raporlarını dışa aktarmak isteyebilirsiniz.

AnalyticaHouse'dan Pro-Tip: Zamanlanmış Taramalar İçin Pratik Kullanım Senaryoları

Zamanlanmış taramaların gücünü tam olarak kullanmak, onu doğru senaryolarda uygulamaktan geçer. AnalyticaHouse olarak bizim de sıkça başvurduğumuz bazı pratik kullanım senaryoları şunlardır:

Haftalık Crawling Check

Haftalık olarak ayarlanan bir görevle özellikle aşağıdaki kritik SEO sorunlarını takip edebiliriz:

- 5xx Sunucu Hatalı Sayfalar

- Yeni Ortaya Çıkan 4xx Sayfalar

- Indexlenebilirlik Sorunları: Yanlışlıkla noindex etiketi eklenmiş veya robots.txt tarafından engellenmiş önemli sayfaları belirler.

- Canonical Etiket Hataları: Yinelenen içerik sorunlarına yol açabilecek hatalı canonical kullanımlarını ortaya çıkarır.

Rakip Analizi

Haftalık veya aylık olarak zamanlanmış rakip taramaları kurarak, onların stratejik hamlelerini otomatize bir şekilde takip edebilirsiniz. Bu taramalarla rakiplerinizin;

- Site yapılarında veya URL hiyerarşilerinde yaptıkları değişiklikleri,

- Hedefledikleri yeni anahtar kelimeleri yansıtan yeni meta title ve description güncellemelerini,

- Ekledikleri yeni içerik bölümlerini veya blog yazılarını*,

- Uyguladıkları yeni Schema (yapılandırılmış veri) türlerini ilk siz fark edebilirsiniz.

Migration (Site Taşıma) Sonrası Kontrol

Taşıma sonrasında eski URL'lerden yenilerine yapılan 301 yönlendirmelerinin doğru çalışıp çalışmadığını sürekli kontrol etmek hayati önem taşır. Tek tek binlerce URL'yi kontrol etmek imkansızdır.

Bunun yerine, eski URL listesini içeren bir liste modu taramasını (List Mode) zamanlayarak bu kontrolü otomatize edebilirsiniz. Bu görev, her gün veya her hafta çalışarak tüm eski URL'lerin hala doğru yeni sayfalara 301 ile yönlendirildiğini teyit eder.

Herhangi bir yönlendirmenin bozulması (örneğin 404'e düşmesi) durumunda anında haberdar olursunuz.

Tüm SEO verilerini Google BigQuery (BQ) üzerinde merkezileştirmek

Bu projenin temel amacı, Screaming Frog, Google Analytics 4 ve Google Search Console'dan gelen verileri tek bir noktada toplayan, ölçeklenebilir ve sorgulanabilir bir veri ambarı oluşturmaktır. Bu sayede, Looker Studio veya Google Sheets gibi araçlarla tamamen otomatize edilmiş, derinlemesine ve özelleştirilmiş raporlar oluşturabilirsiniz.

- Schedule Timing: Taramanın zamanı ve tekrarı için düzenleme sağlanır.

- GA4 & GSC Entegrasyonu: API yetkilendirilmesi ile taramaya dahil olan her bir URL’nin gerçek zamanlı Google verisi elde edilir.

- Big Query & URL Detayı: Big Query’e aktarılan veri üzerinden URL path’ine göre sayfa türü yer alır. (Örneğin; /blog, /kategori, /urun gibi)

- GA4 & GSC Kaynaklarından Veri Aktarımı: Entegre edilecek performans metrikleri işaretlenir. (Örneğin; GA4 Oturum Sayısı (Sessions), GA4 Satın Alım Sayısı (Purchases), GA4 Gelir (Revenue), GA4 Dönüşüm Oranı (Conversion Rate %), GSC Gösterim Sayısı (Impressions), GSC Tıklama Sayısı (Clicks), GSC Tıklama Oranı (CTR), GSC Ortalama Pozisyon (Average Position))

- Fonksiyonel Raporlama: URL segmentasyonu ile sisteme toplu bir URL listesi yükleyerek sadece o sayfaların zaman içindeki performansını izleme ve raporlama imkanına erişilir. BigQuery'de yaratılacak olan tablo ile Looker Studio ve Google Sheets ile kusursuz bir şekilde entegrasyon çalışır. Bu sayede, anlık olarak güncellenen interaktif dashboard'lar ve otomatik raporlar oluşturmak mümkün hale gelir.

More resources

Bir Analytics Ajansı ROI’yi Nasıl Etkiler?

Dijital pazarlama dünyasında başarı yalnızca reklam bütçesine veya kampanya çeşitliliğine bağlı deği...

2026 SEO Beklentileri ve Trendleri: Yapay Zeka, GEO ve E-Ticaret Stratejileri

2025 yılını geride bırakırken, dijital pazarlama dünyası daha önce hiç olmadığı kadar büyük bir kaym...

Google MMM ile Satış Artışlarını Doğru Ölçmenin 5 Yolu

Google MMM (Marketing Mix Modeling), pazarlama karması modellemesi olarak bilinen bu yöntem, çerezsi...